【セッションレポート】 日本初、デジタルツインキャスティングの可能性と制作の裏側 ~AI・フォトグラメトリースキャン・バーチャルプロダクション・Unreal Engine 5~

2022年11月7日から5日間にわたって「CGWORLD2022クリエイティブカンファレンス」が開催された。本イベントはゲーム・映像・アニメ・インタラクティブアートなど、CGに携わるすべての方を対象とした国内最大級のカンファレンスイベントであり、多数の企業や技術者の方々に登壇いただいた。今回はその中から、株式会社サイバーエージェントによる「日本初、デジタルツインキャスティングの可能性と制作の裏側 ~AI・フォトグラメトリースキャン・バーチャルプロダクション・Unreal Engine 5~」の講演内容をお届けする。

今回登壇いただいたのは、株式会社サイバーエージェント リサーチサイエンティストの吉本 暁文氏、エンジニアの海木 一佳氏、株式会社CyebrHuman Productions CGディレクターの田森 敦氏、CGアーティストの中澤 勤氏だ。

まずは最初に、サイバーエージェントの事業内容について簡単にご説明いただいた。

「サイバーエージェントは大きく三つの柱がありまして、メディア、ゲーム、インターネット広告を中心に事業を展開しています。僕たちが所属しているのはインターネット広告領域にあるAI事業本部で、その中にCyebrHuman Productionsがあります。3DCGに関しては2017年ごろから取り組んでおり、そこからここ5、6年の事業内容において積極的に3DCGやXR技術、バーチャル撮影技術といったものを取り入れています。2019年には現在のCyberHuman Productionsが誕生しました。」(田森氏)

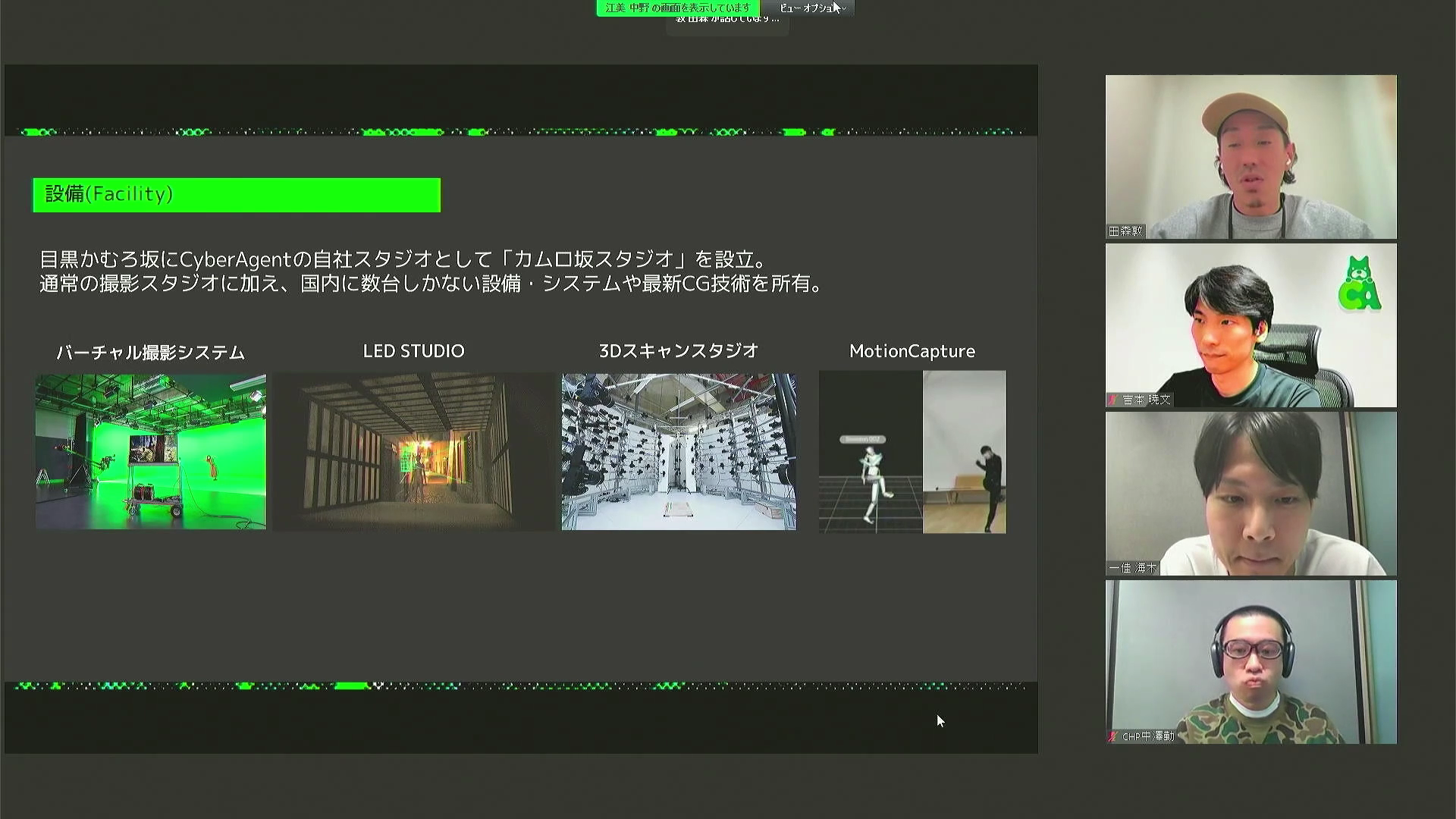

設備面では、目黒かむろ坂にサイバーエージェントの自社スタジオとして、「カムロ坂スタジオ」が設立された。通常の撮影スタジオに加え、リアルタイムにCG合成をおこなえるスタジオや3Dスキャンスタジオ、モーションキャプチャ設備など、国内トップクラスの先端設備が集められている。

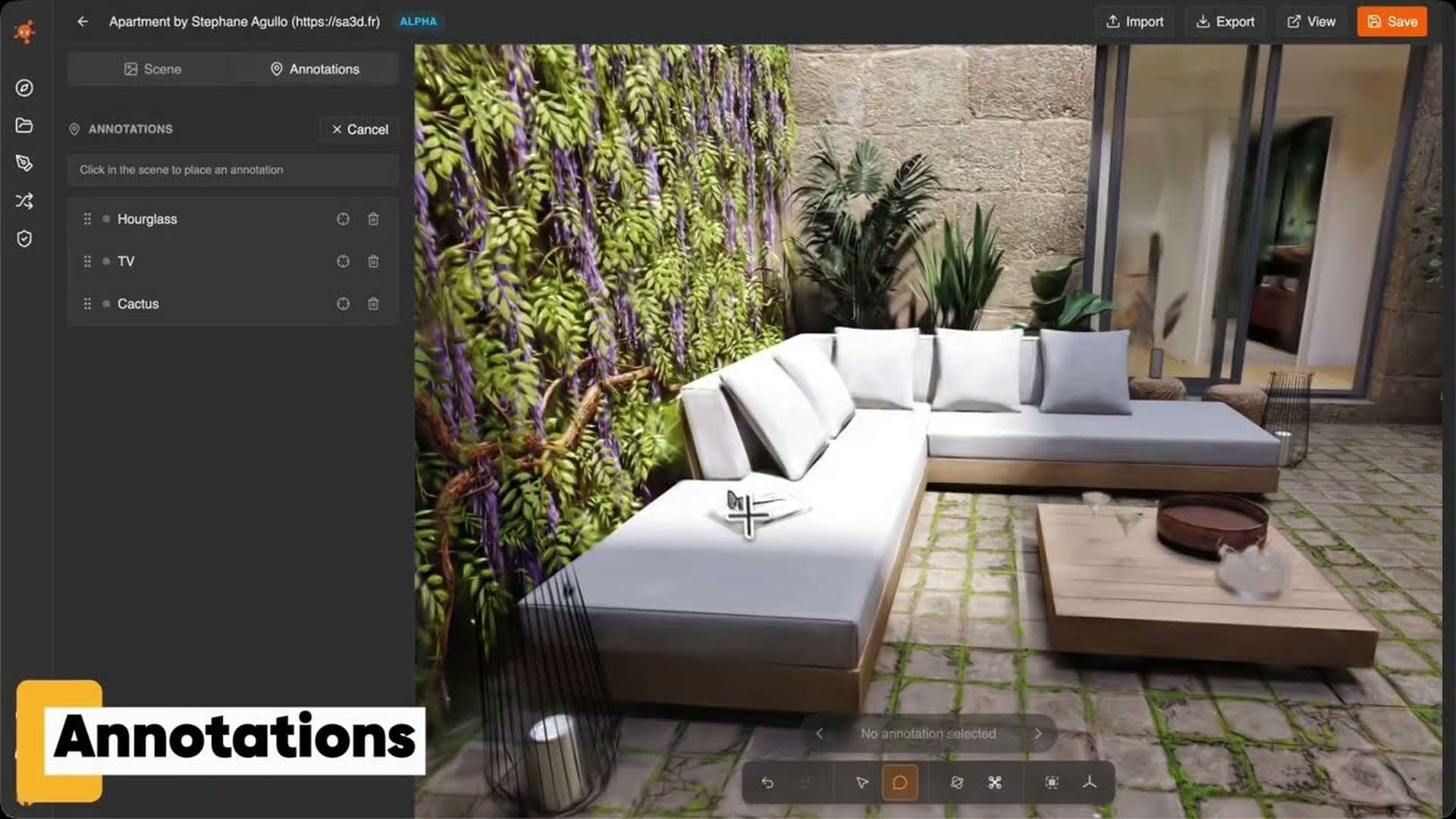

「我々は技術開発と設備投資を続け3DCGを広告に活用し、未来の当たり前を社会実装していくことをビジョンに掲げています。事業ドメインとして、まず一つ目は広告制作ですが、これも単に3DCGで広告制作をするということではなく、広告制作をどんどんDXしていくということですね。次にイベントテック、これはフューチャーライブと呼んでたりもするんですけど、リアルタイムで3DCGと実在の人物を合成できるシステムを使って、オンライン上のイベントをもっと革新的に面白いものにしていくという事業です。それから、今日のお話のメインのひとつであるデジタルツイン事業ですが、デジタルツインをキャスティングしていこうというサービスです。あとはスポーツ観戦をDXするという事業、最後にバーチャル店舗というのは、企業ブランディングに合わせた小空間をバーチャルで提供するというものです」(田森氏)

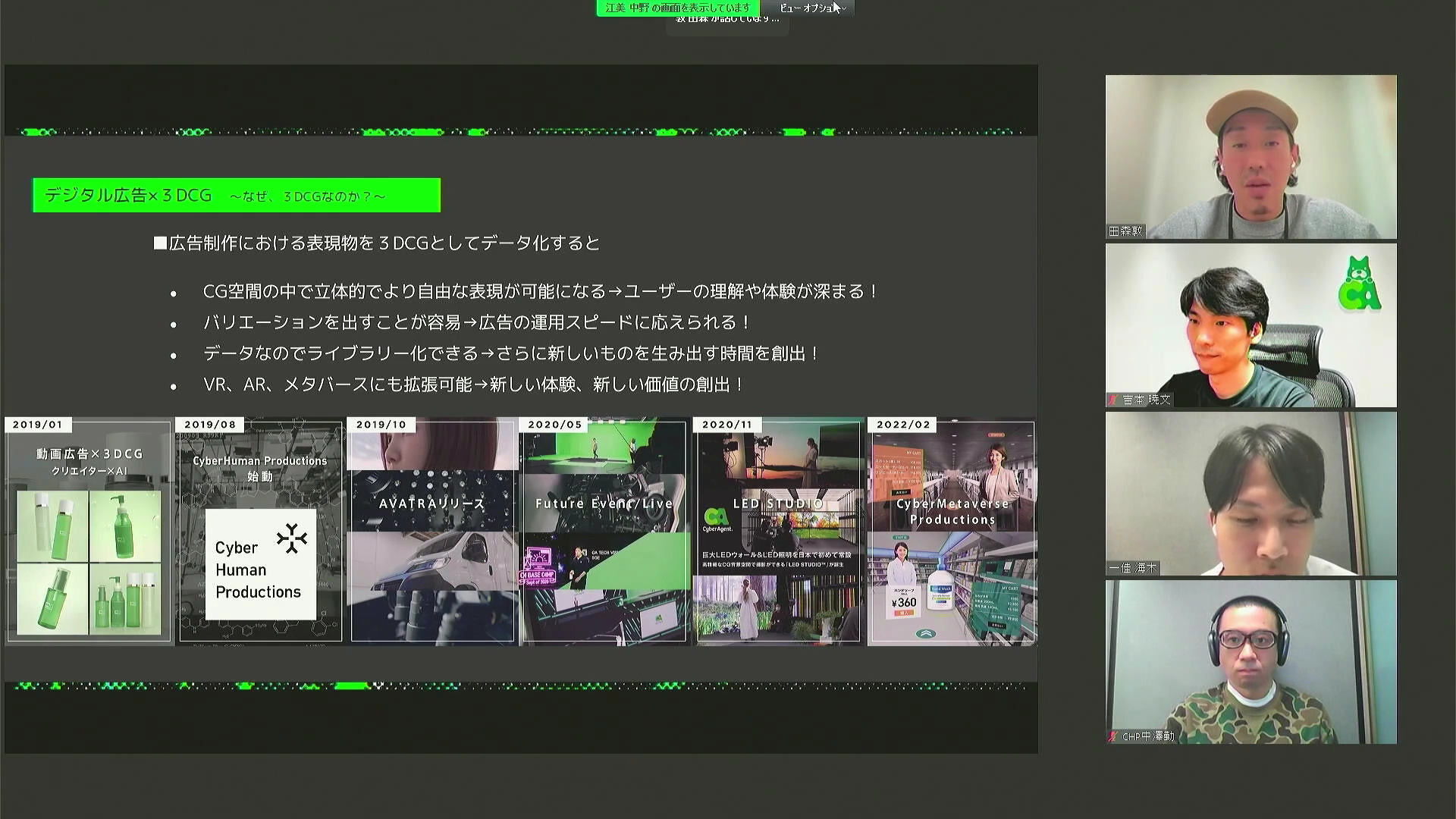

近年の目まぐるしい通信環境やデバイスの進化によって、インターネット広告にも大きな変化がもたらされているという。2Dデータである動画や静止画はより高品質なものが求められるようになっており、VR、AR、メタバースなど、3Dデータが活用される場も拡大の一途を辿っている。そんな状況において、同社はユーザーのコミュニケーション体験を3DCGやXR技術などを用いて、革新的にDXさせることに取り組んでいる。

「デジタル広告に3DCGを活用することには、いくつかのメリットがあります。まず、CG空間の中で立体的でより自由な表現が可能になることで、ユーザーの理解や体験が深まるという点。またバリエーションを出すことが容易なので、広告の運用スピードに答えられるという点。データなのでライブラリー化が容易であり、さらに新しいものを生み出す時間が創出できるという点。そしてVR、AR、メタバースといった、近年需要が高まっている新たな体験にも拡張が容易であるという点が、3DCGを使うメリットとして挙げられます」(田森氏)

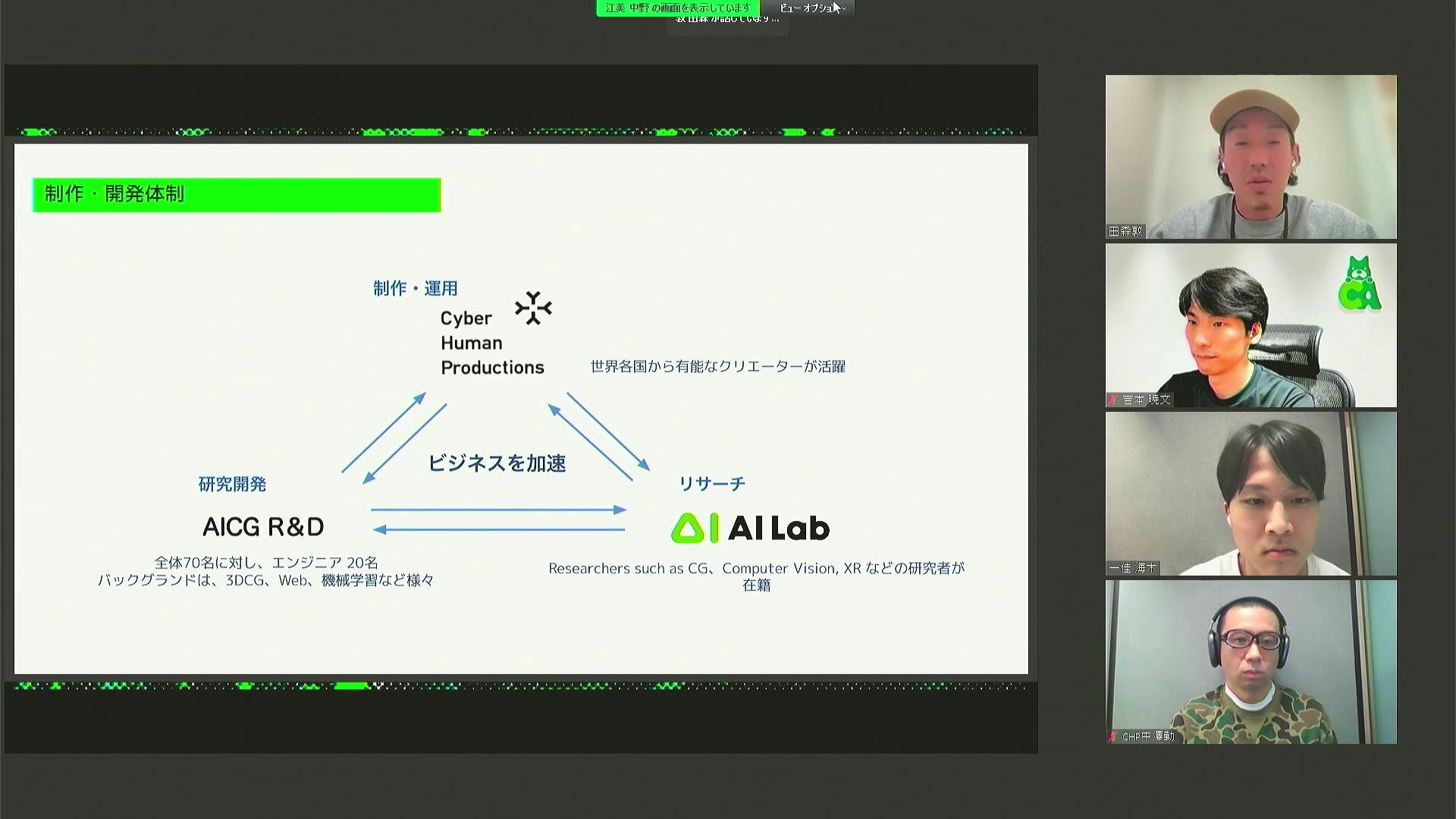

またサイバーエージェントグループでは、制作・運用、研究開発の三種の事業全てをグループ内で保有しているため、フットワークが軽く、最先端の技術を即R&Dして実戦投入することができるのも強みとなっている。

三菱地所レジデンス ザ・パークハウス広告、制作の裏側

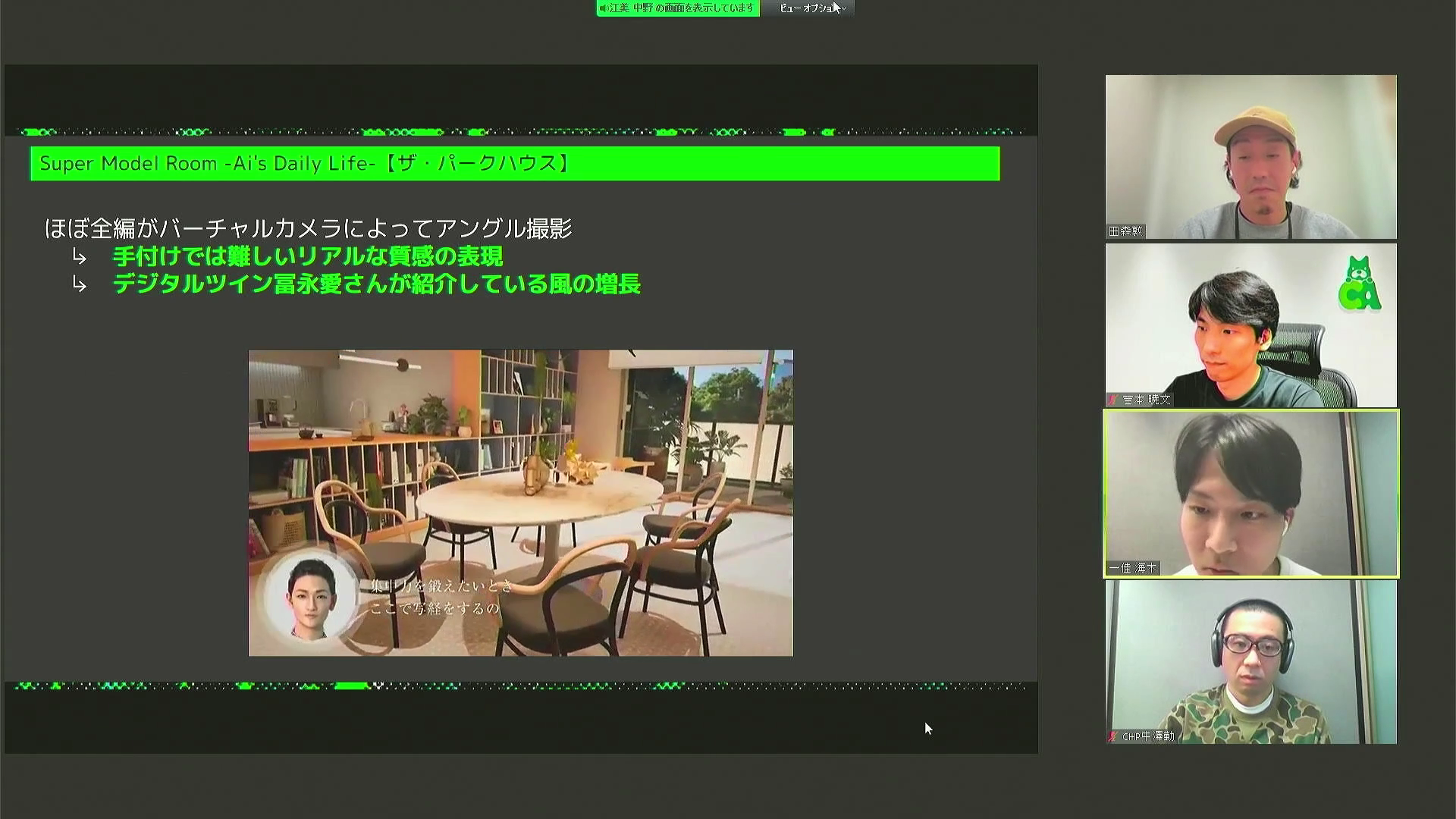

続いて、三菱地所レジデンス ザ・パークハウスの広告事例について、制作の裏側などについて語っていただいた。

「今回のプロジェクトで見ていただきたいポイントは、まずデジタルツインの冨永愛さんをキャスティングしたことです。さらに、実際のザ・パークハウスの部屋をスキャンして3DCG化したという点です。また、もし冨永さんがそこに住むとしたらどのような家具を置きたいかなどもお伺いして、冨永さん自身のライフスタイルをそこに再現するという取り組みをおこないました」(田森氏)

【AIの音声合成手順】

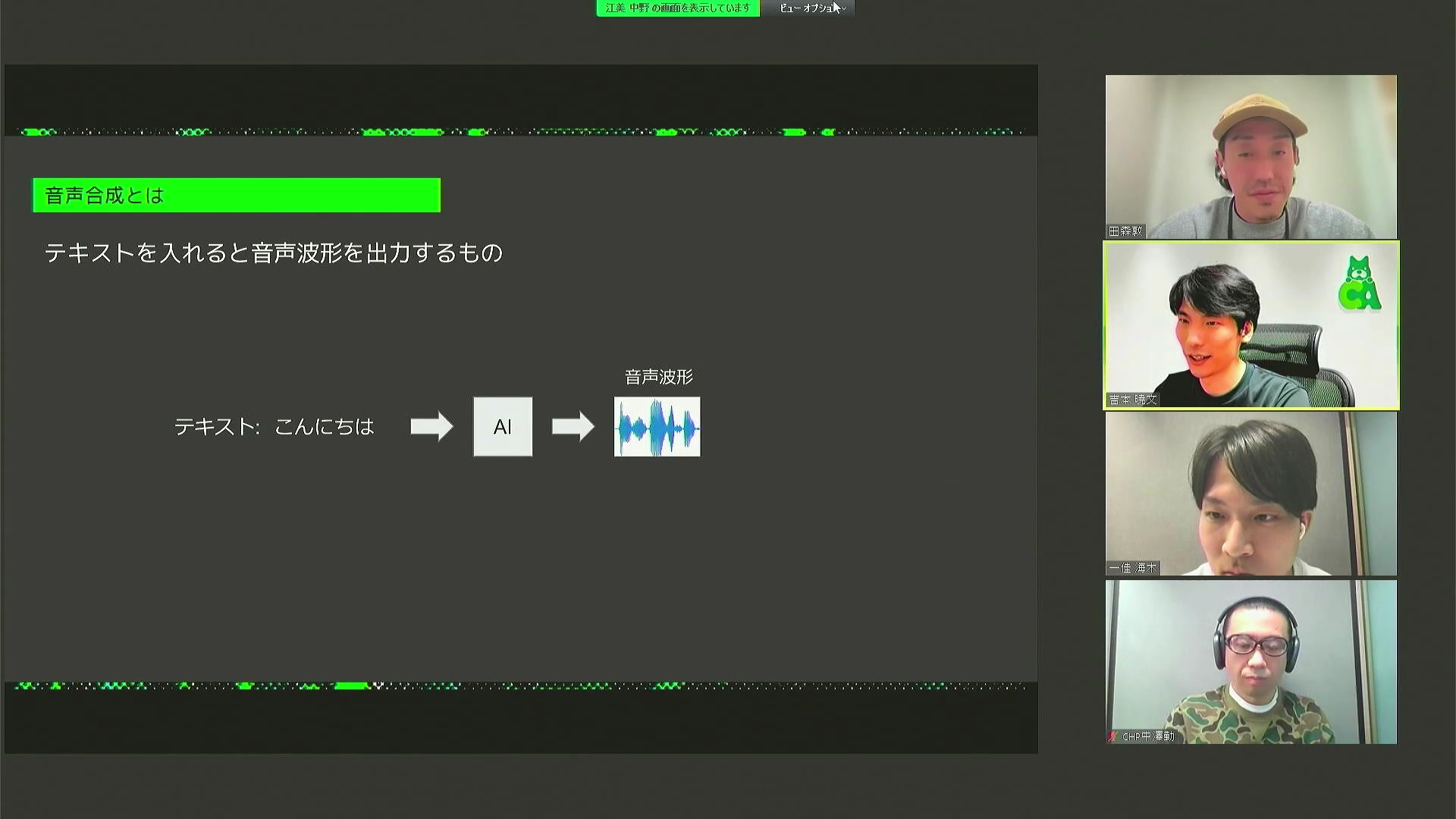

ここからは順を追って、このCMがどのような手順で作られていったかを解説していただく。まずは吉本氏より、AIの音声合成についてのお話をうかがった。

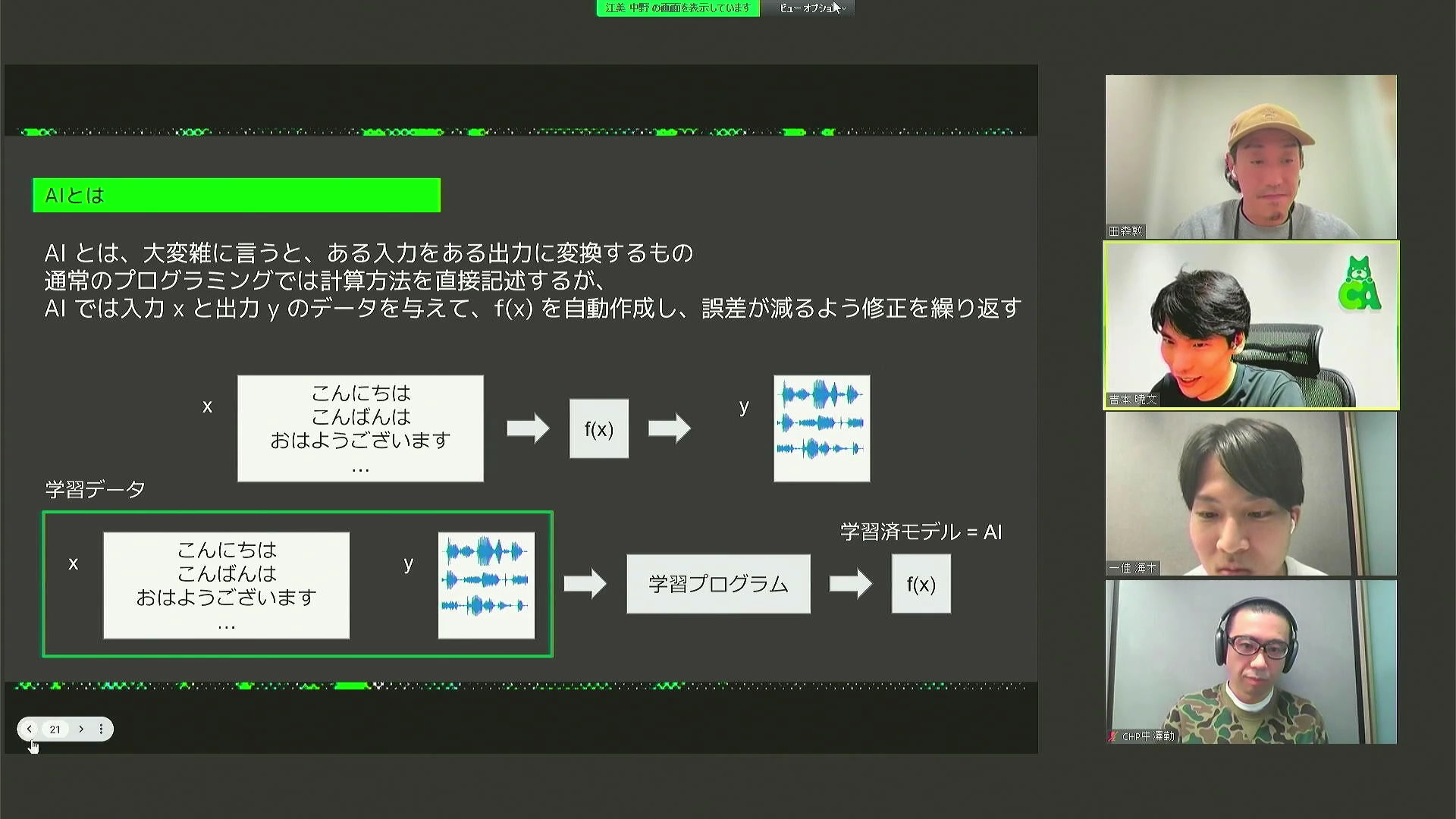

「AIの音声合成とは、簡単に言うと、テキストや声に関する指示を入れると音声波形が出力されるものです。例えばテキストは「こんにちは」、話者は「冨永愛さん」、話し方のスタイルは「穏やか」というような指示を入れることで、その指示に沿った音声波形が出力されます。AIとは大雑把に言うと、ある入力をある出力に変換するもの、という説明になります。通常のプログラミングでは計算方法を直接記述するのですが、AIでは入力xと出力yのデータを与えて、f(x)を自動作成し、誤差が減るように修正を繰り返していきます。それを何百万回と繰り返して、本物に近付けていきます」(吉本氏)

「与えるデータが最終的なAIの性能を決めてしまうので、どうやっていいデータを用意するかがAI作成において一番大事なんです。今回、冨永さんの声を再現するためにいいデータを集める方法としてやったことは、次の六つです。まず収録台本の作成です、二番目が生成したい声質の収録です。通常、台本にはよく「音素バランス文」(日本語を読む上で必要な音が過不足なく散りばめられている文)というものが使われます。ただし、音素バランス文をそのまま最終的に欲しいスタイルで読むことは難しいので、ライターさんの協力のもと、最終的に欲しい喋り方になりやすい文を多数作成し、音声を収録しました。

三つ目は音声合成向けの整音です。音声録音は、理想を言えば無響室で収録するのが望ましいのですが、しかし現実的には、全く声の反響のないところで喋るのは難しいのです。そこで自然な程度に残響がある部屋で録音し、録音技師さんに残響や鳴りの抑制を含めて整音をしていただきました」(吉本氏)

「続いて四つ目、五つ目の工程は、音声合成の試作と生成スタイルの確認です。まずは、台本と違うところに読点が入った状態で収録されたりしているところや、読み間違いがあるところを修正していきます。さらにアクセントも付けていきます。そして実際に使いそうな文で音声を生成してみましたが、まだ最初のうちは違和感のある声になっていました。リファレンス音声を使って生成すると冨永さんらしさが損なわれてしまい、微調整が大変でした。そこで、並行して進めていた大規模収録データを用いて、日本語一般のアクセントやテンポを学習させたものをベースに、転移学習でターゲット音声を学習させると、アクセントやテンポが圧倒的に改善されました」(吉本氏)

【フォトグラメトリとバーチャルカメラの活用】

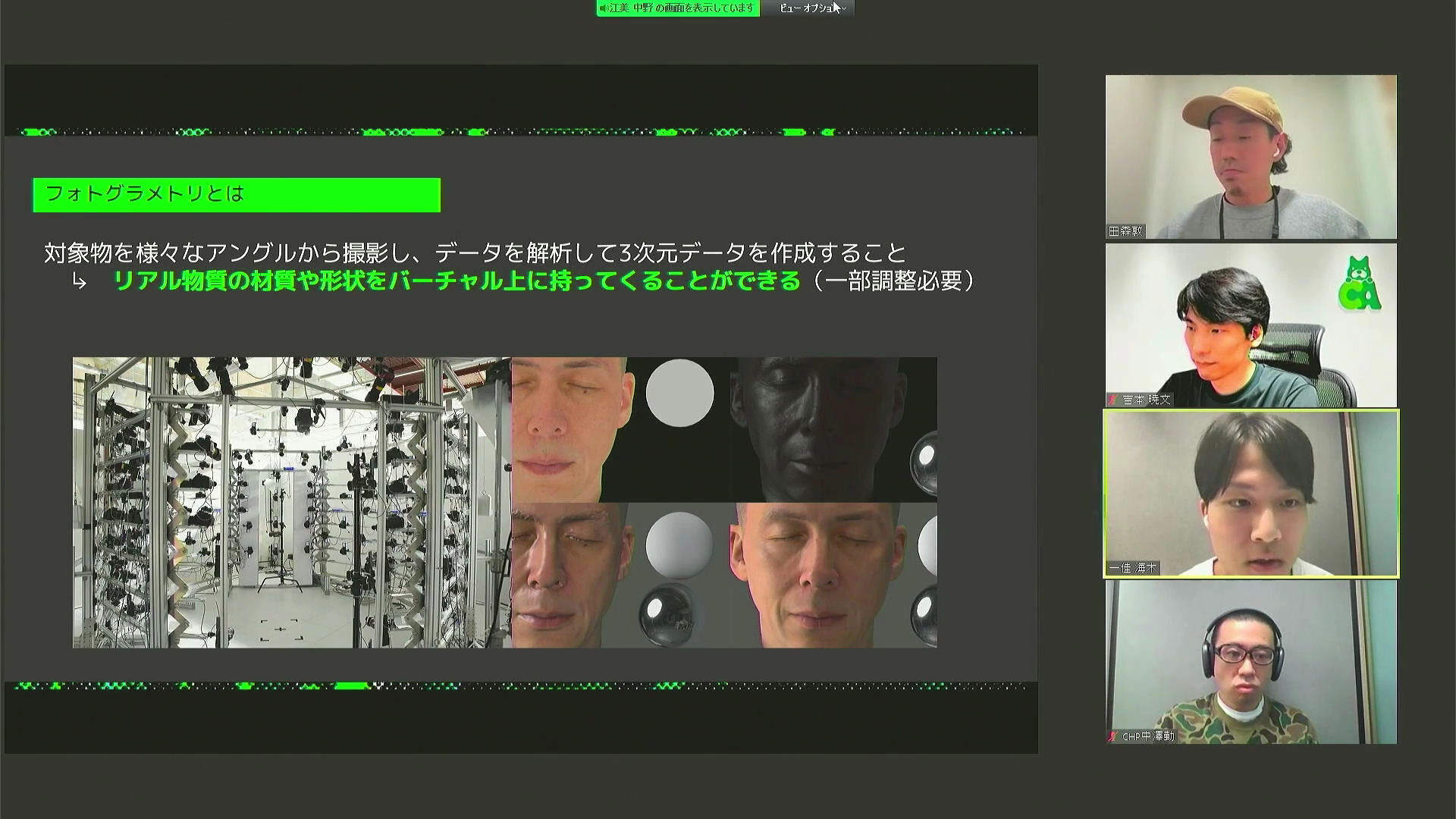

続いて、フォトグラメトリについて海木氏よりお話いただいた。

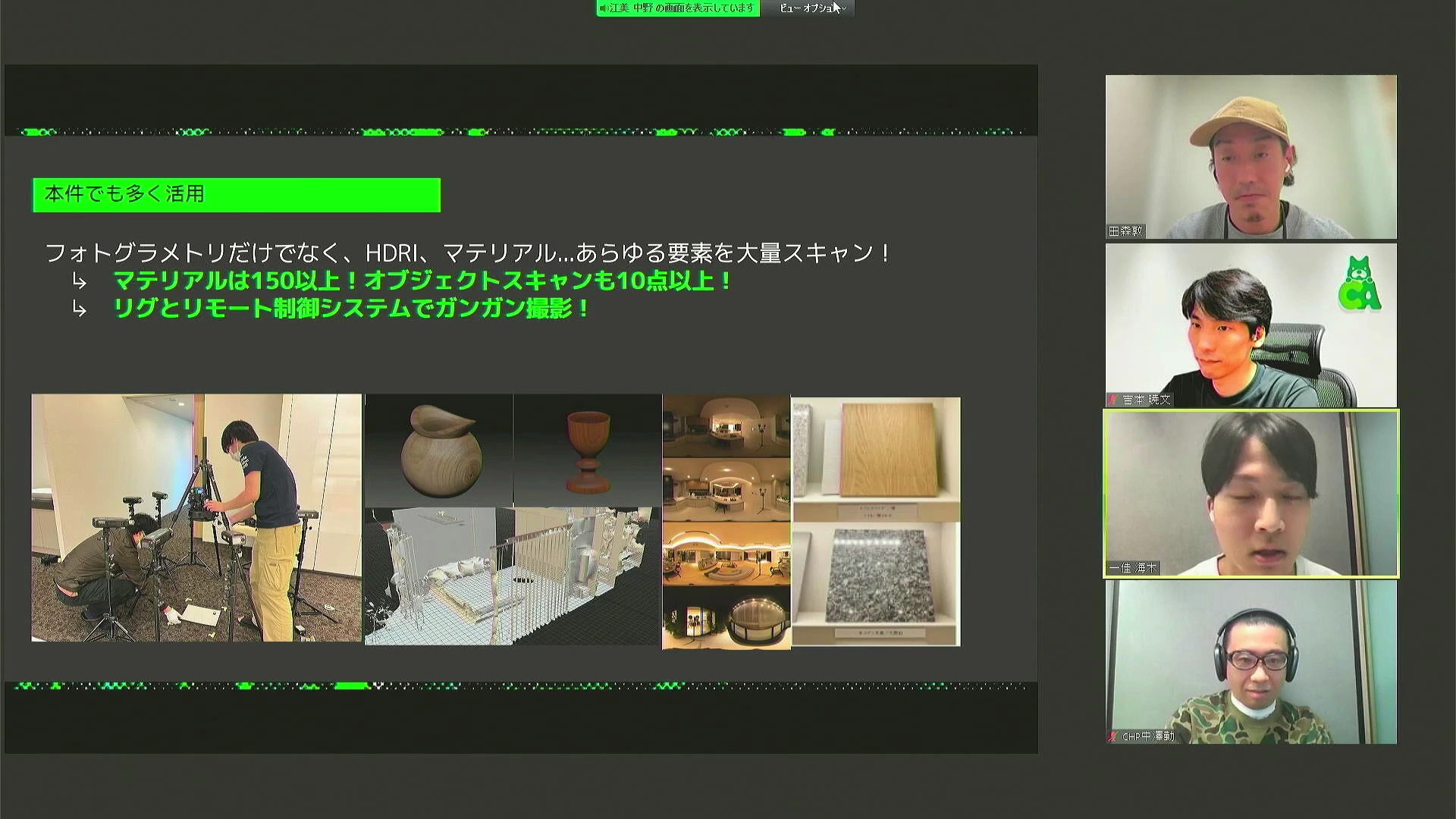

「フォトグラメトリとは、対象物を様々なアングルから撮影し、そのデータを解析することで3Dデータを作成する技術です。この手法を使うことにより、リアル物質の材質や形状を、バーチャル上に持ってくることが可能になります。今回の事例では、フォトグラメトリだけではなく、リアルな光の入り方を再現するためのHDRI、壁や机などの質感を再現するためのマテリアルスキャンも多数おこないました。今回の撮影では短時間に多くのものを撮影しなければならなかったので、専用照明やカメラ用のリグを制御するリモートシステムを作り、活用することで時間短縮をしています。また小物だけはなく、部屋全体にもフォトグラメトリとレーザースキャンをおこなっています。これらの技術を活用することで、大幅な工数の削減と、リアルな部屋を再現することを両立させることに成功しました」(海木氏)

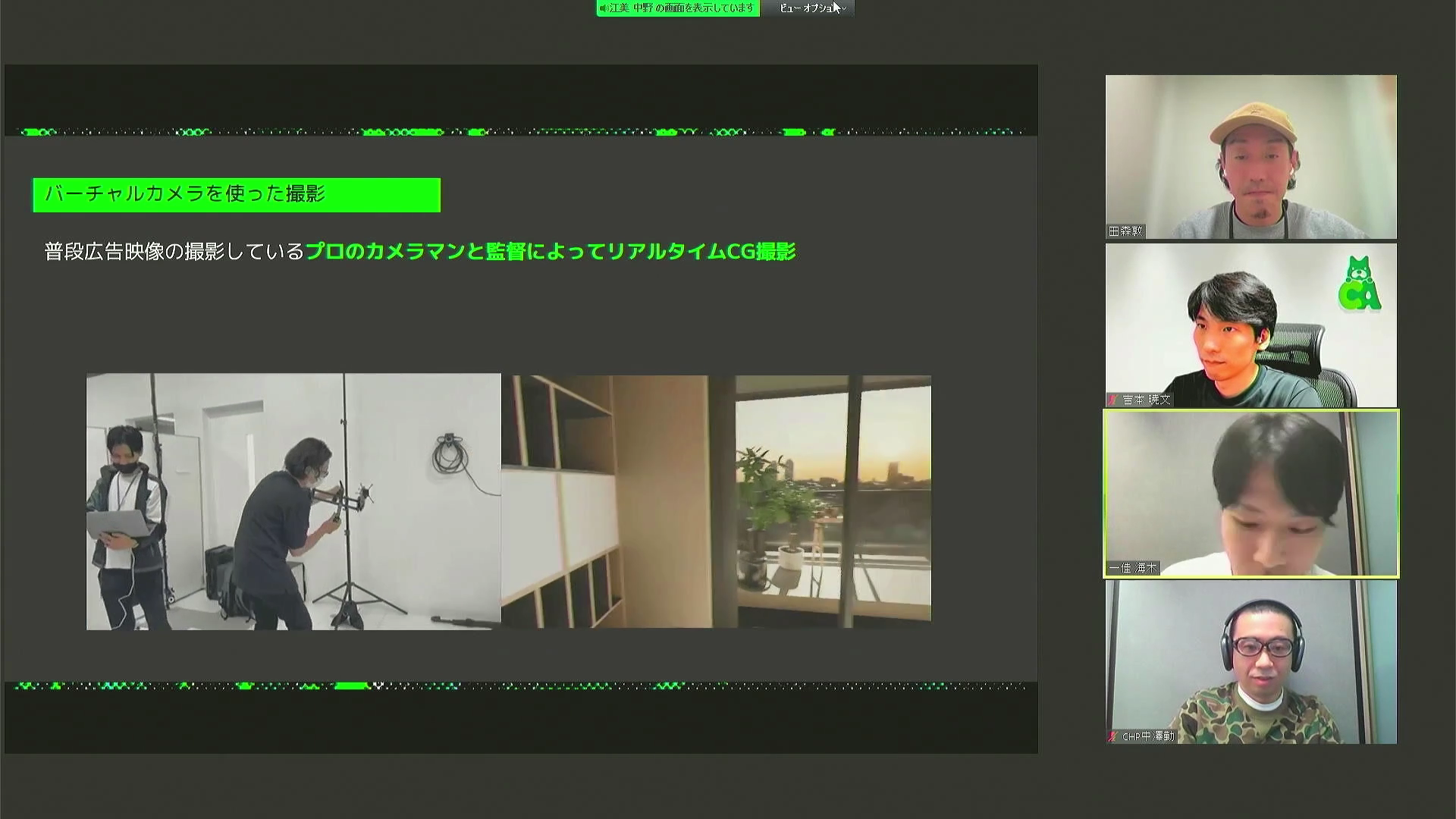

また、今回の事例ではフォトグラメトリとともに、バーチャルカメラも積極的に活用されているという。

「今回制作した映像は、アニメーターさんが手付けで動きを付けたのではなく、ほぼ全編がバーチャルカメラによって撮影されたアニメーションが使われています。普段は広告映像の撮影をしているプロのカメラマンと監督が、実際にリアルのカメラを動かして、それに連動してUnreal Engine 5でリアルタイムにレンダリングされていく映像を見ながら収録しました。この手法を選択したことによって、手付けでは難しいリアルな質感の表現をすることが可能になりました。また、わずかなカメラのブレなどによりデジタルツインの冨永愛さん自身が部屋を紹介している感覚を増す効果も期待できます」(海木氏)

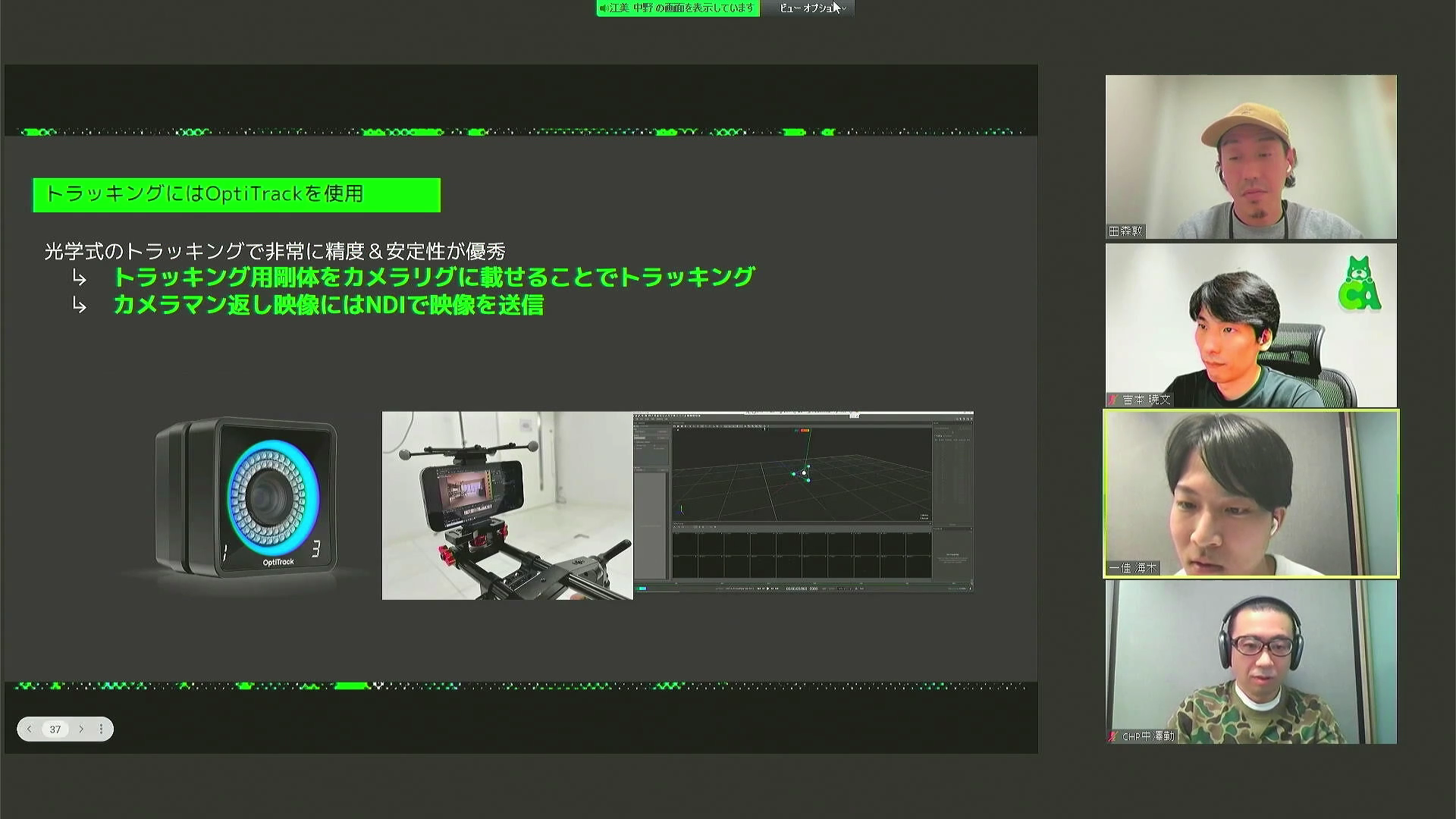

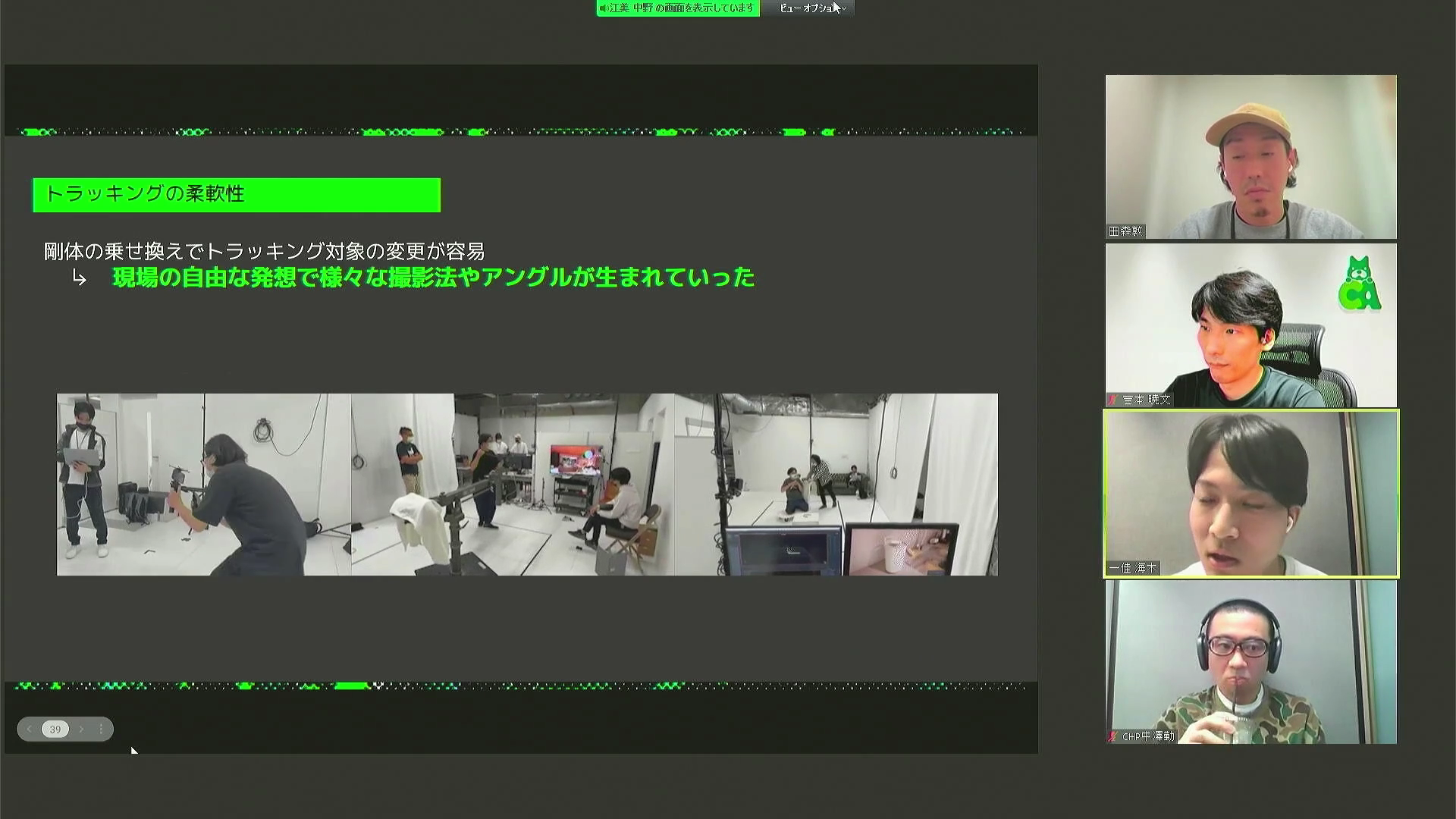

「カメラのトラッキングにはOptiTrackを使用しました。光学式のトラッキングなので、非常に精度と安定性が優秀でした。また、カメラマンへの返し映像にはNDIで映像を送信しました。トラッキング対象の変更が容易だったため、カメラを自由自在に動かすことが可能になり、現場の自由な発想で様々な撮影法やアングルが生み出されました。」(海木氏)

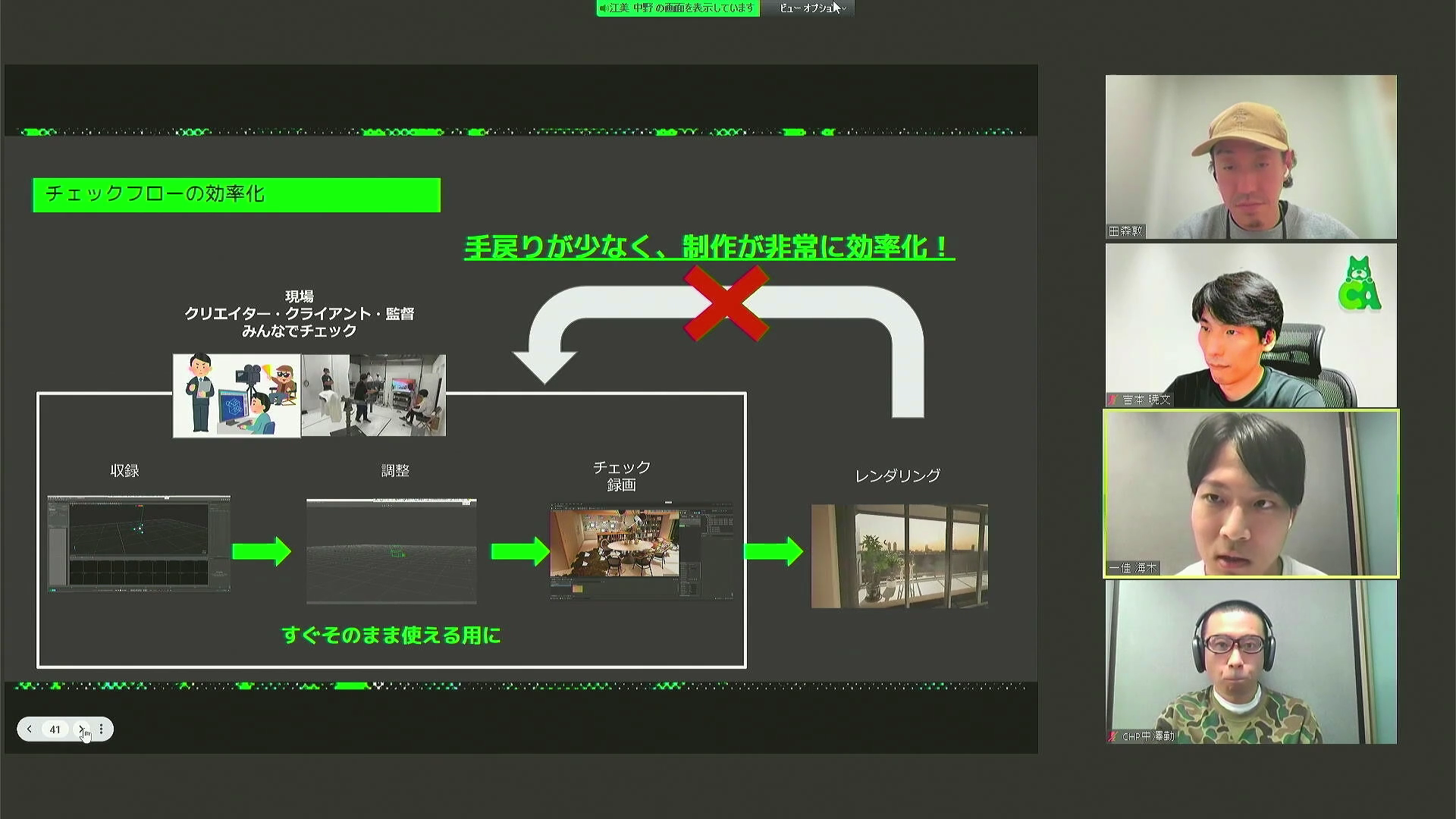

「さらにバーチャルカメラの利点として、チェックフローの効率化が挙げられます。手付けのアニメーションは工数がかかって大変な上に手戻りも多く発生するのに比べ、バーチャルカメラを使うことで、現場で監督やカメラマン、クリエイター、クライアントがみんなでリアルタイムで内容をチェックでき、成果物のチェックが効率化されました」(海木氏)

【Unreal Engine 5の導入とシーン構築について】

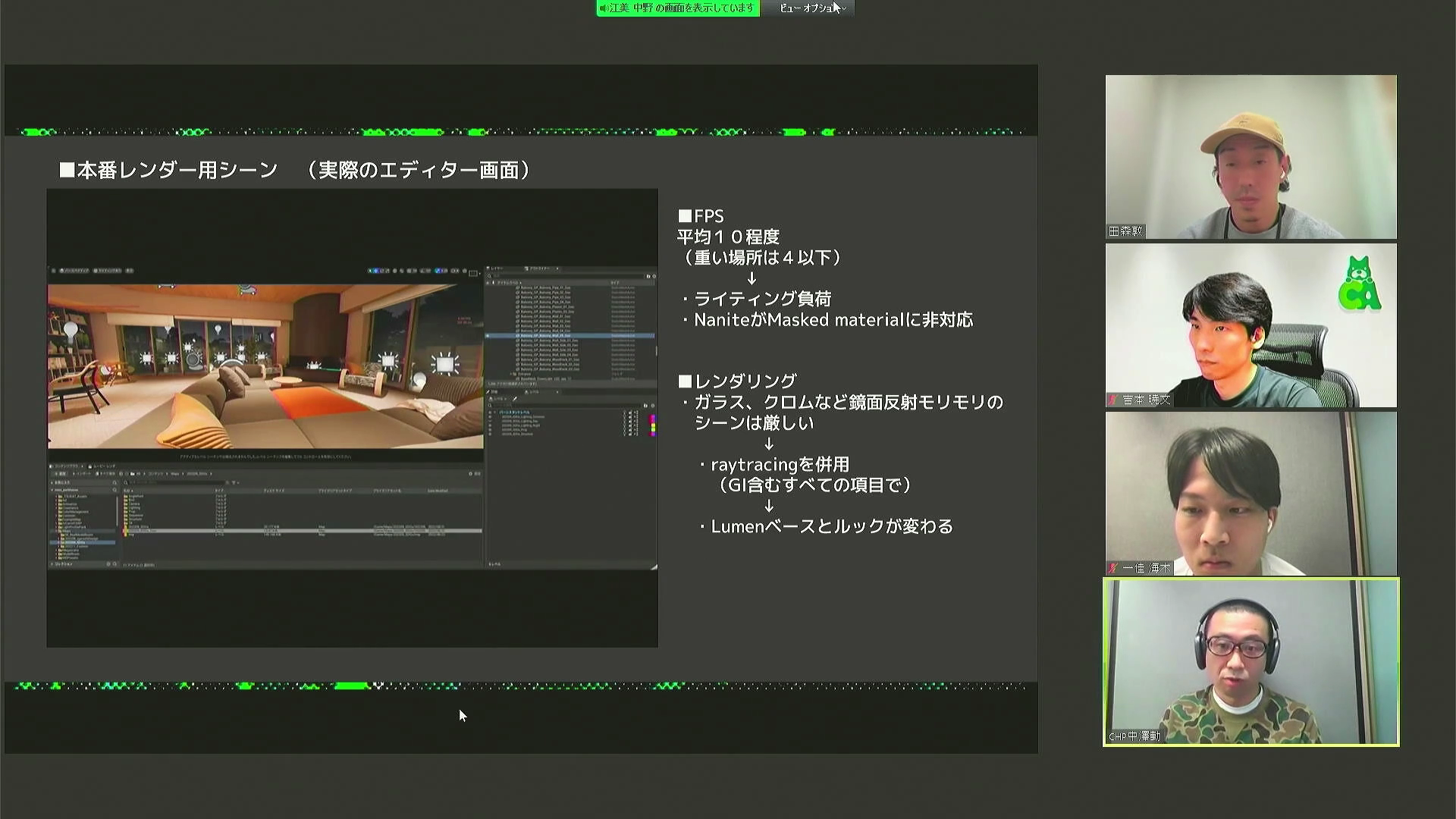

最後に中澤氏より、Unreal Engine 5を導入したことによるメリットや、それにまつわるトライアンドエラーについて解説していただいた。

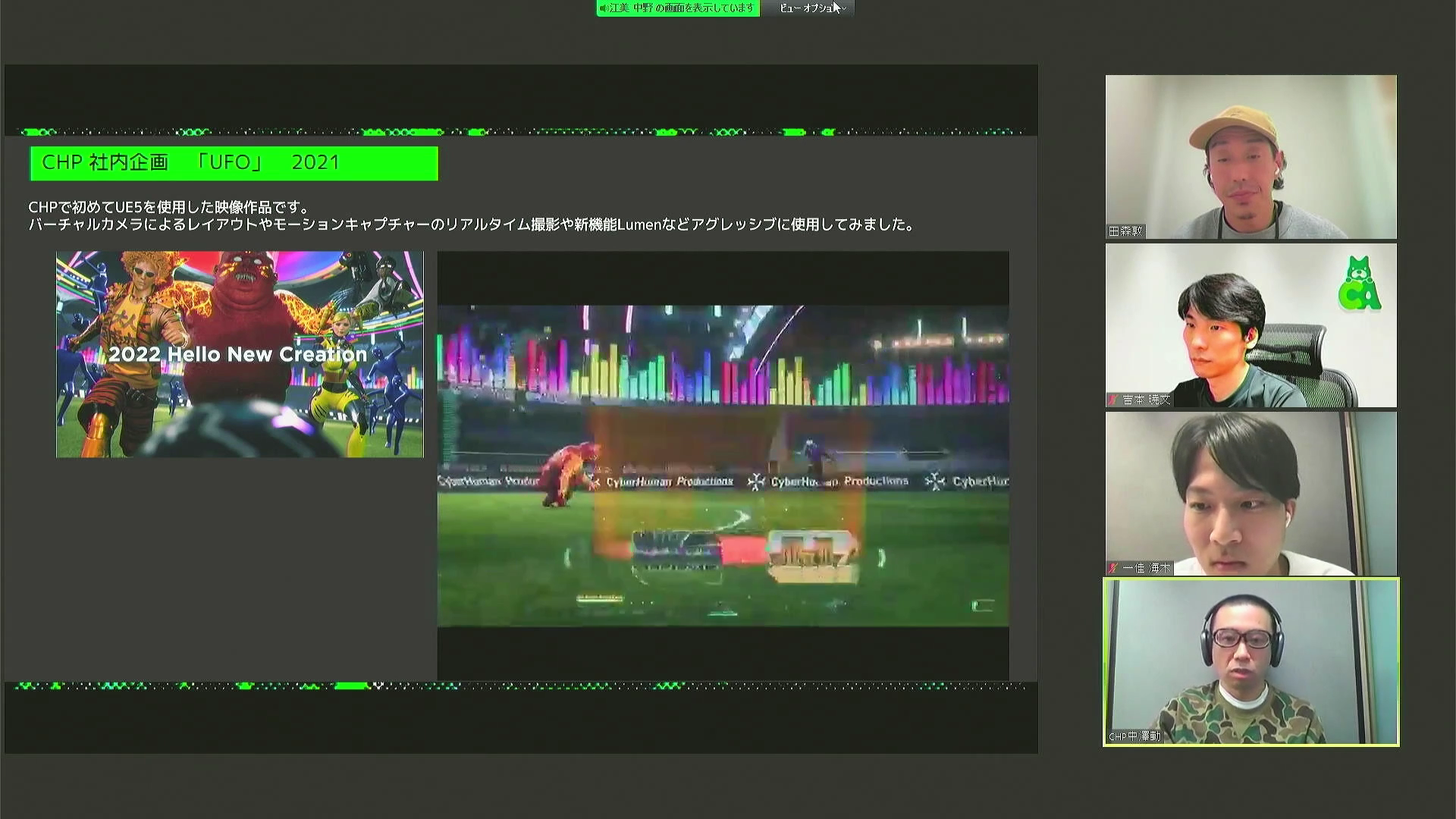

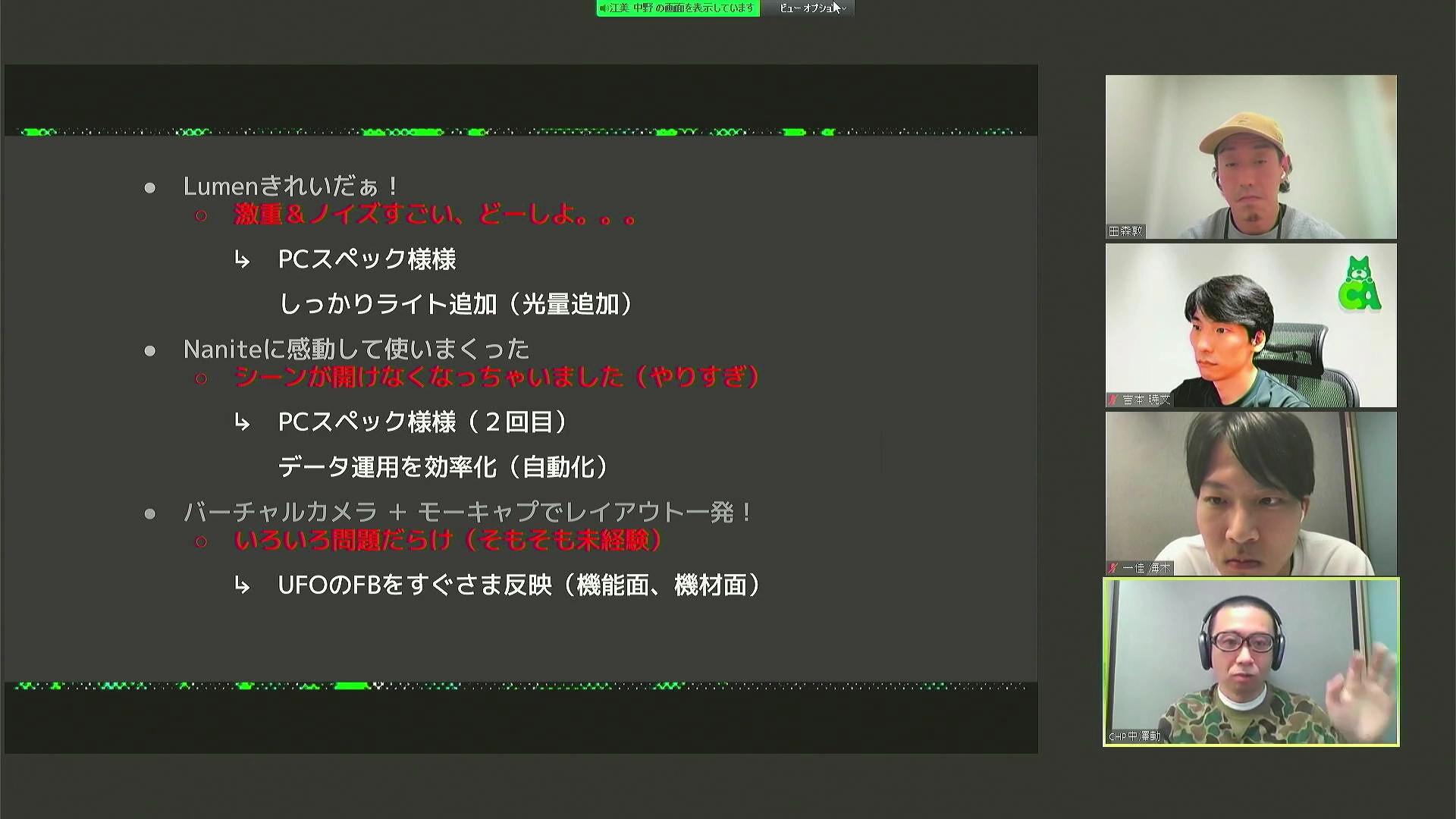

「Unreal Engine 5を今回の案件で使用する前に、実は「UFO」という社内企画で使ってみたことがあります。全てUE5のプレビュー版で作った映像になります。当初はLumenやNaniteを活用してどんどんクオリティを上げていったり、レイアウトが楽になっていくと考えて、社内プロジェクトで使ってみたんですが、初めてだらけで難易度は高かったです。ライティングは激重になってしまうし、シーンが開けなくなってしまうし、バーチャルカメラも色々と問題だらけでした」(中澤氏)

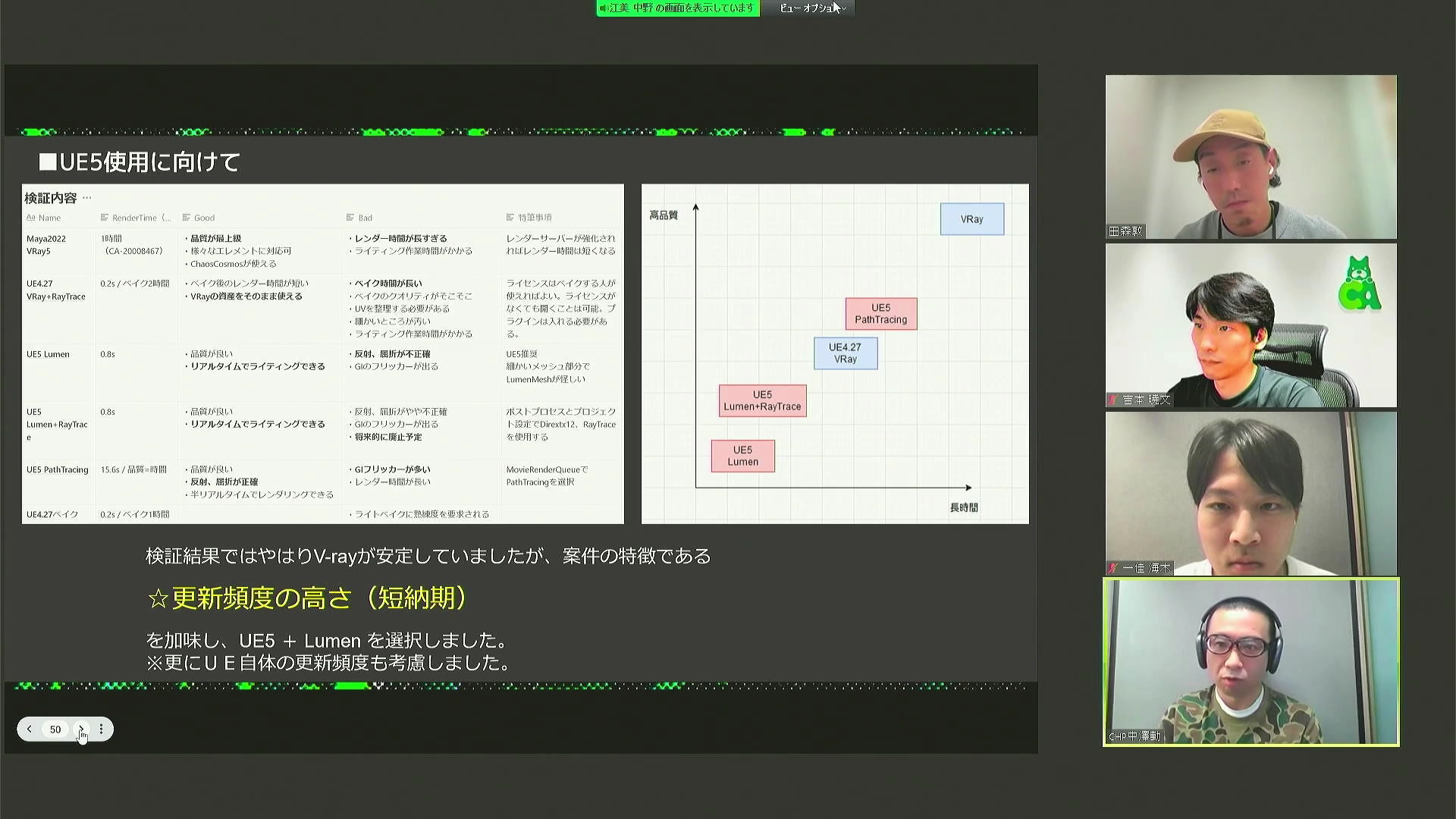

「ただ、その「UFO」での失敗の経験をふまえた上で、その反省を活かすべく、今回の「ザ・パークハウス」の広告案件に取り組ませていただきました。まずはUE5使用に向けて、いきなり本番で使う前に、検証をおこないました。UE5とプリレンダを比較してみると、やはり品質ではV-Rayが安定していました。しかし今回の案件の特徴として、更新頻度が高く納期が短いということがあったので、時間の問題で考えると、UE5を使うべきだという結論に至りました」(中澤氏)

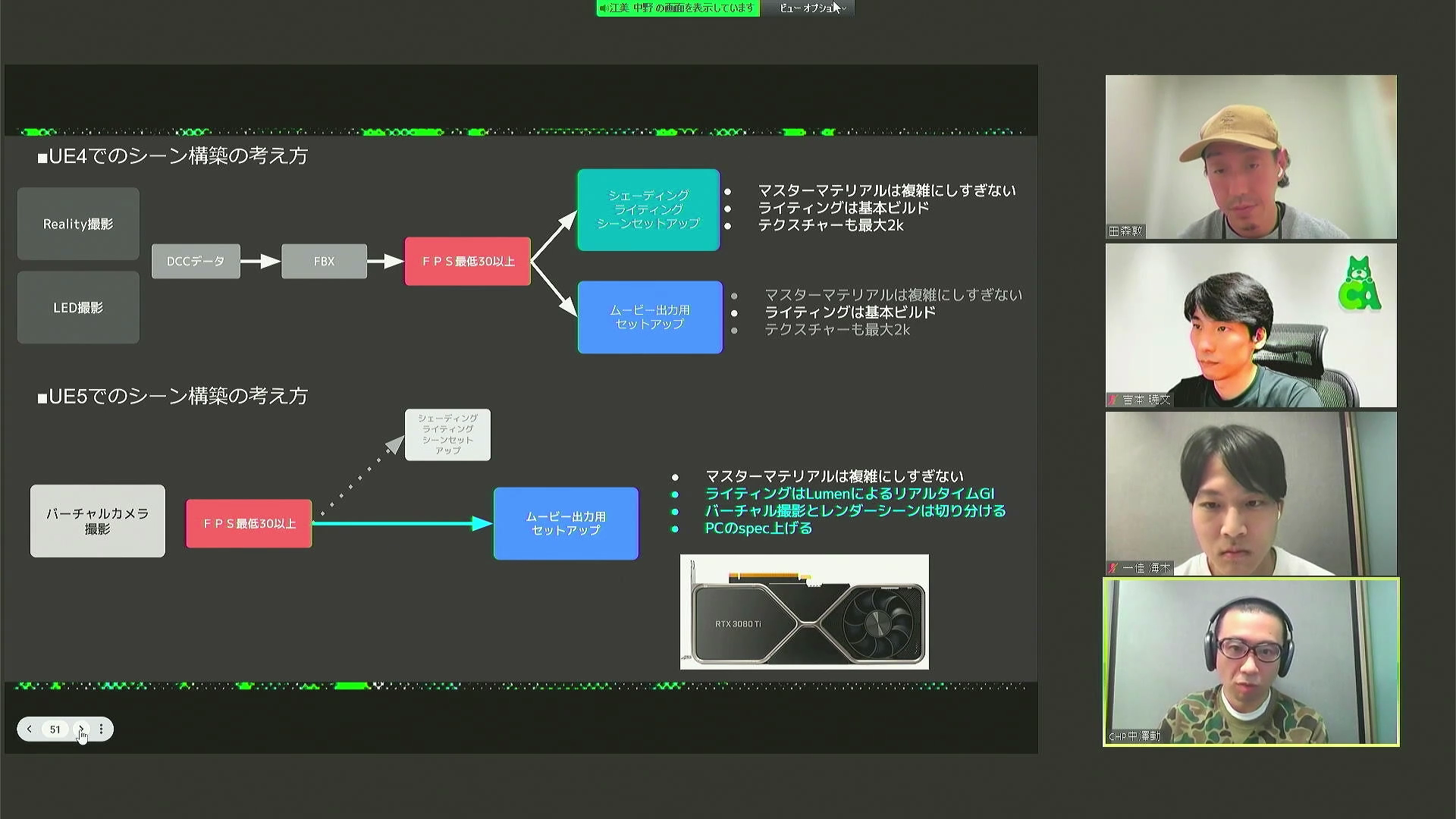

「UE5のシーン構築の考え方としては、バーチャル撮影で、CG空間の中とiPhoneで撮った映像がリンクするように、FPS30以上を確保することはマストでした。それ以降は基本的にレンダリングした素材を納品するかたちでしたので、ムービー出力用のセットアップをおこないました。また、マスターマテリアルを複雑にし過ぎない、ライティングはLumenによるリアルタイムGIをどう達成するかということも考えました。また、検証を経た上でPCのスペックを挙げるということもしています」(中澤氏)

「バーチャルカメラでやっているシーンは、FPS30を目標にしていたので、比較的軽いアセットにしつつライティングのほうにプライオリティを割いて、リアルっぽいシチュエーションで撮影することができました。ただ本番のシーンはフォトリアルにするために、どうしても光量が必要になったので、FPSとしては10以下になってしまいました。また、今は対応しているんですが、当時はMasked materialがNaniteに対応しておらず、植物が多かったので、そのあたりの負荷が高くなってしまいました。また、浴室などはガラスやクロムなどが多く、反射、透過が多いシーンでも負荷がかかるので、LumenやレイトレーシングGIをどこまで適用するかは悩みつつ、それらを併用することで解決していきました。」(中澤氏)

「「UFO」で直面した問題をどう解決していったかをまとめますと、まずLumenの重さやノイズに対しては、シンプルですがPCスペックを上げること、それからライトをしっかり追加することで乗り切りました。また、やりながらデータ運用を効率化する、例えばマテリアルのコンバートを自動化することをやっていきました。また僕らは運用をメインにしているので、ことあるごとにフィードバックをプロジェクトに反映するということをしていました」(中澤氏)

「以上で終了となります。AI、フォトグラメトリースキャン、バーチャルプロダクション、UE5において我々が挑戦して課題をクリアしていった過程が伝わるものになっていましたら幸いです。ご清聴ありがとうございました」(田森氏)