南洋理工大学と上海AIラボからなる研究チームは11月18日(火)、1枚の日常的な画像から物理シミュレーションですぐに使用可能な3Dアセットを生成するフレームワーク「PhysX-Anything」を発表した。コードはGitHubで、データセットはHugging Faceで公開されている。ライセンスは独自の「S-Labライセンス」で、利用目的が研究および教育に制限されている。

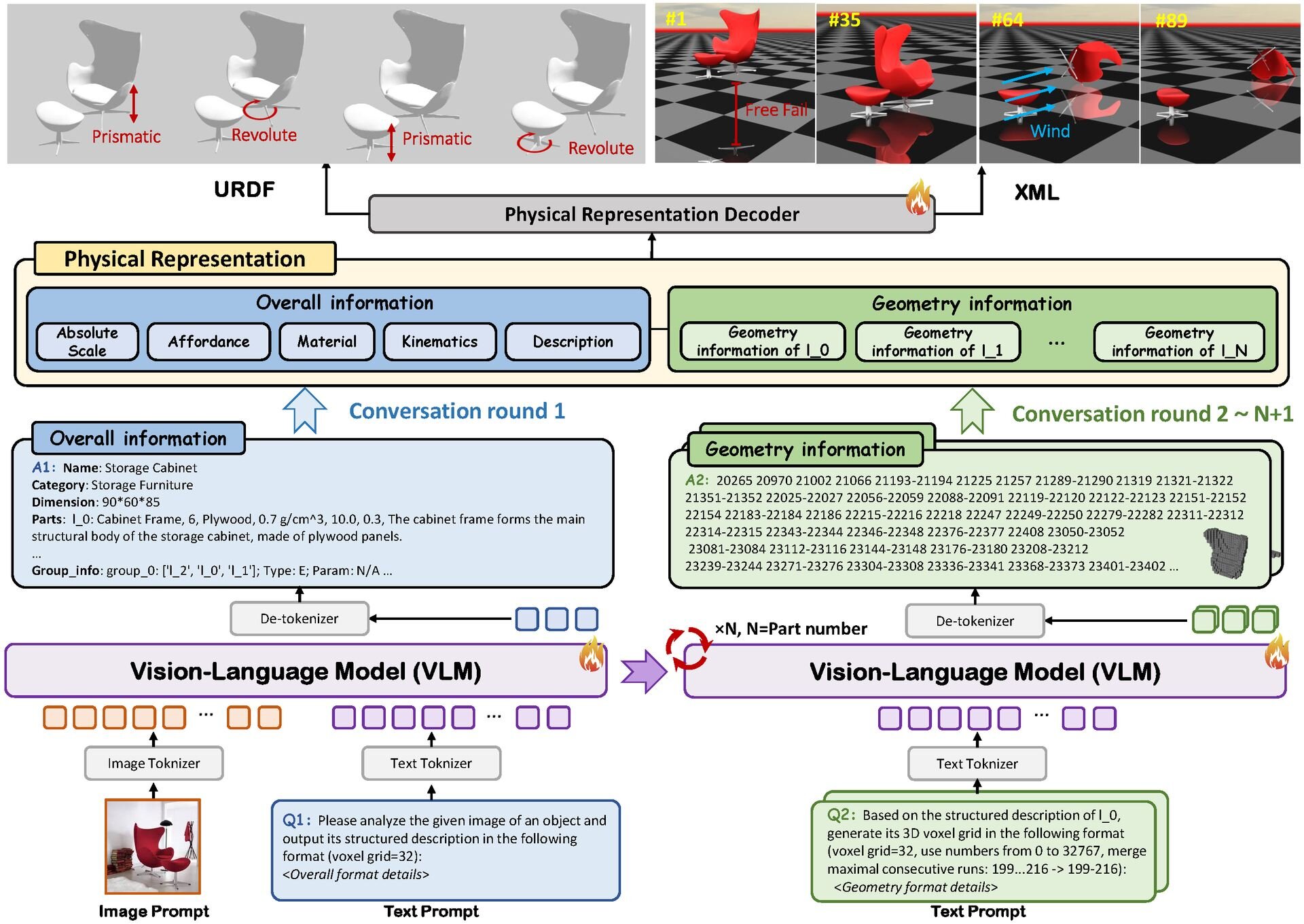

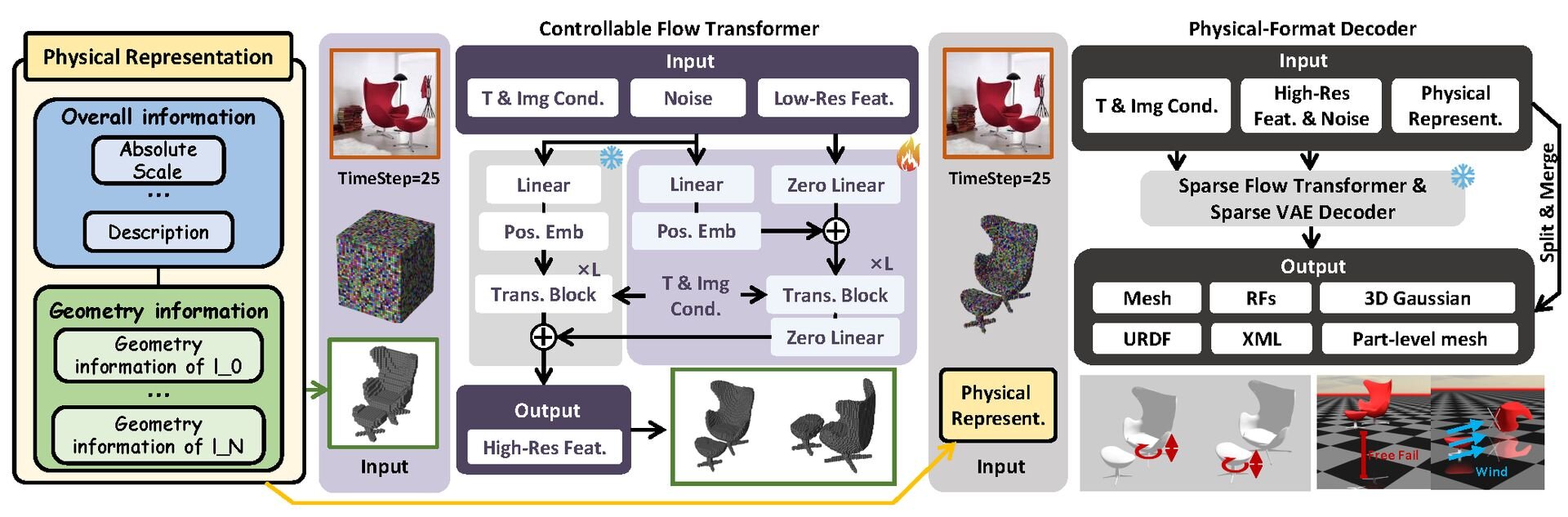

「PhysX-Anything」は、大規模視覚言語モデル(VLM、Vision-Language Model)を活用することにより、AIが画像からジオメトリ・リグ(関節構造)・物理属性を推定し、シミュレーション空間で実際に動作可能なデータを生成する技術。形状を表現するためのデータ量(トークン数)を従来比で193分の1にまで削減したことにより、一般的なAIモデルの処理能力の範囲内で、高精度の物理シミュレーション対応3Dアセット生成が可能となったという。

研究チームは今回、物理特性を持つ3Dデータセットの不足を解消するため、新たに「PhysX-Mobility」を構築。これは既存の同種データセットと比較して、物体のカテゴリ数を2倍以上に拡大し、2,000以上の一般的な実物体に詳細な物理的アノテーション(Physical Annotations)を付与したものである。これにより、AIはより多様な物体について物理的なふるまいを学習できるようになった。

生成されたアセットは、物理演算エンジン「MuJoCo」などの環境に直接読み込むことができる。実験では、これらのアセットを用いて、接触を伴う複雑なロボット制御の方策学習(Robotic Policy Learning)に成功。ロボットなどの物理的な身体を通じて現実世界や物理シミュレーション空間に働きかける、身体性AI(具現化AI、Embodied AI)分野での実用性を実証したという。

PhysX-AnythingはURDF(Unified Robot Description Format)、MJCF(MuJoCo XML)、SDF、glTF、OBJ、PLYの6フォーマットでエクスポートできる。ロボット工学から物理シミュレーション、Web表示まで、用途に応じた柔軟なデータ活用が可能となっている。

■PhysX-Anything: Simulation-Ready Physical 3D Assets from Single Image(プロジェクトページ、英語)

https://physx-anything.github.io/

■PhysX-Anything: Simulation-Ready Physical 3D Assets from Single Image(GitHub)

https://github.com/ziangcao0312/PhysX-Anything

■PhysX-Mobility(Hugging Face)

https://huggingface.co/datasets/Caoza/PhysX-Mobility

CGWORLD関連情報

●Metaの3D生成AI技術「SAM 3D」発表! 単一の2D画像から精密な3Dオブジェクトや人物を再構築、GitHubとHugging Faceでコード&データ公開

Metaが画像セグメンテーションAIの最新モデル「Segment Anything Model 3(SAM 3)」と、単一画像から3Dモデルを再構築する「SAM 3D」を発表。ソースコードはGitHubで公開されているが、独自ライセンスによって「SAM 3」基盤モデル、「SAM 3D Body」、「SAM 3D Objects」が明確に区分されている。データセットはHugging Faceで公開されているほか、同社AI技術のプレイグラウンド「Meta AI Demos」ではブラウザ上でSAM 3Dをテストできる。

https://cgworld.jp/flashnews/01-202511-Meta-SAM3D.html

●バイトダンス、オープンソースの単眼深度推定技術「Depth Anything 3」発表! 単一画像、多視点画像、動画のいずれからでも空間的整合性の取れたジオメトリを推定する基盤モデル

ByteDance Seedが単眼深度推定技術「Depth Anything 3」を発表。任意の数の画像入力から、カメラポーズの既知・未知を問わず、空間的に整合性の取れたジオメトリを予測する基盤モデル。ソースはGitHubで、デモはHugging Faceで公開されている。用途や規模に応じた複数のモデルシリーズが、2種類のライセンス(Apache-2.0またはCC BY-NC 4.0)で提供される。

https://cgworld.jp/flashnews/01-202511-DepthAnything3.html

●ByteDanceの3Dアセット生成基盤モデル「Seed3D 1.0」発表! 画像1枚から物理シミュレーションに対応可能な高品質アセットを生成

ByteDance Seedが3Dアセット生成基盤モデル「Seed3D 1.0」を発表。単一の画像から物理シミュレーションに対応可能な高品質3Dアセットを生成できる。Seed3D 1.0は同社運営の企業向けクラウドサービスプラットフォーム「Volcano Engine」で利用できる。

https://cgworld.jp/flashnews/01-202511-Seed3D.html