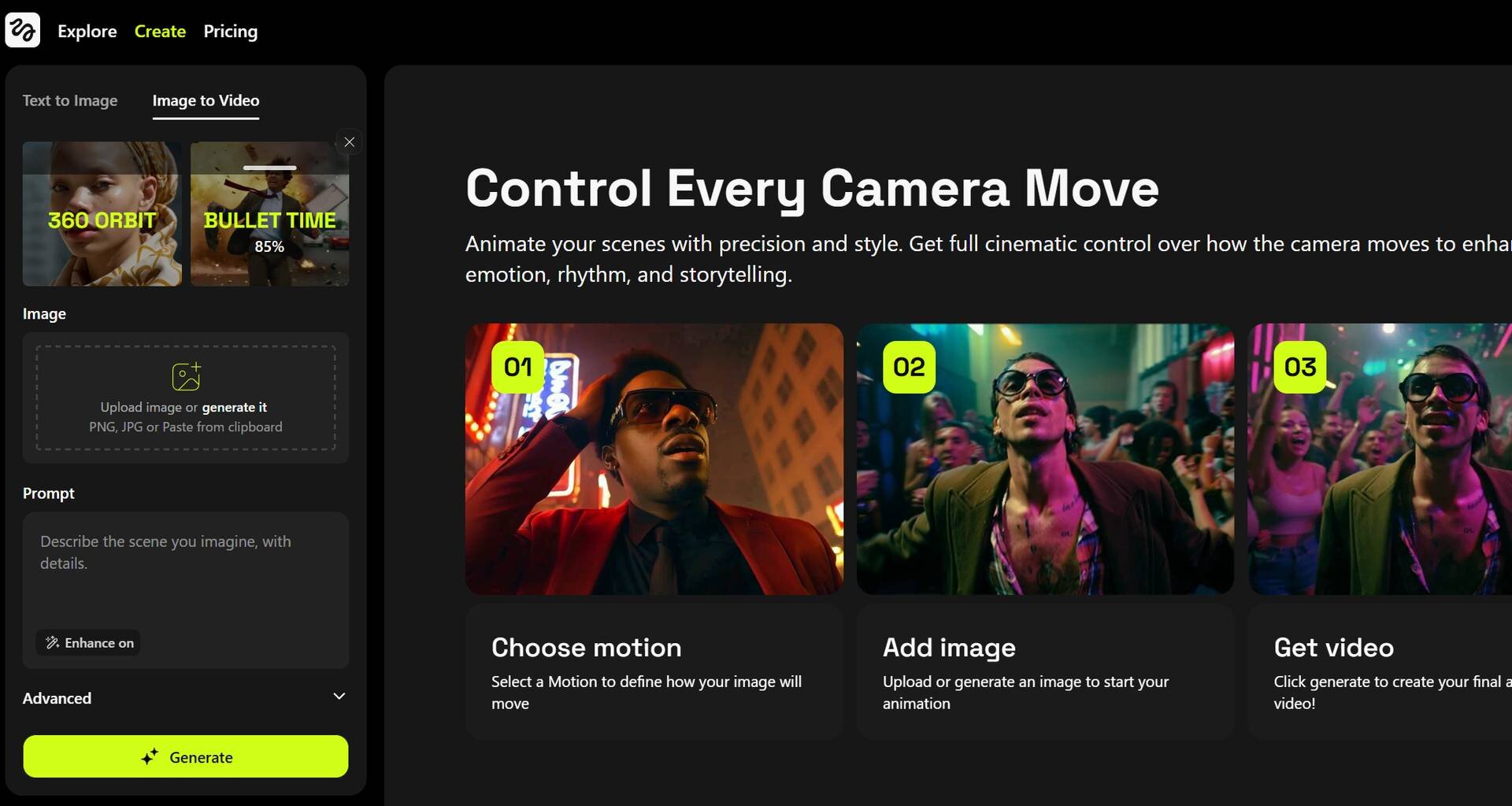

アメリカHiggsfield社は4月1日(火)、同社動画生成AIプラットフォーム「Higgsfield」に新しい動画生成AIモデル「Higgsfield DoP I2V-01-preview」をリリースした。プリセット化された多様なカメラモーションコントロールによりシネマティックな動画を生成できるほか、1ショットに2つのモーションコントロールをミックスできる「Higgsfield Mix」(4月11日実装)も利用できる。

Now, AI video doesn’t have to feel lifeless.

— Higgsfield AI (@higgsfield_ai) March 31, 2025

This is Higgsfield AI: cinematic shots with bullet time, super dollies and robo arms — all from a single image.

It’s AI video with swagger.

Built for creators who move culture, not just pixels. pic.twitter.com/dJdQ978Jqd

同社は従来の動画生成AIモデルについて、「意図とコントロールが欠けている」(Because they lack intent and control.)、つまり映画的な文法や一貫性を持ったストーリーテリングの視点が欠けていると指摘。その点「Higgsfield DoP I2V-01-preview」AIモデルは、拡散(diffusion)の後にカメラ&レンズワーク、ライティング技術、シーン構造などの芸術的要素について強化学習を適用し、DoP(撮影監督)のように訓練をしたという。

Side-by-side: Higgsfield vs Google Veo 2 pic.twitter.com/MiqsvsZyO6

— Higgsfield AI (@higgsfield_ai) March 31, 2025

Higgsfield AIで実現可能な撮影表現例

「Higgsfield DoP I2V-01-preview」では、実に45種類以上のモーションコントロールのプリセットが用意されている。

CRASH ZOOM IN pic.twitter.com/SBEm3yWHSF

— Higgsfield AI (@higgsfield_ai) March 31, 2025

ROBO ARM pic.twitter.com/elfGuiNyWk

— Higgsfield AI (@higgsfield_ai) March 31, 2025

SNORRICAM pic.twitter.com/JDneYoBfrF

— Higgsfield AI (@higgsfield_ai) March 31, 2025

CRANE OVER THE HEAD pic.twitter.com/lZG83cTBNE

— Higgsfield AI (@higgsfield_ai) March 31, 2025

FISHEYE pic.twitter.com/AKlNIBFUei

— Higgsfield AI (@higgsfield_ai) March 31, 2025

Forget everything you know about camera motion.

— Higgsfield AI (@higgsfield_ai) April 5, 2025

These 10 underrated styles, all built into Higgsfield, are what filmmakers will be using next.

You just haven’t seen them in the wild yet.

1/10 pic.twitter.com/CTVsSuwCe0

HEAD TRACKING pic.twitter.com/VTVjoO8Odz

— Higgsfield AI (@higgsfield_ai) March 31, 2025

HEAD TRACKING pic.twitter.com/mB7WTJkqo2

— Higgsfield AI (@higgsfield_ai) April 5, 2025

WHIP PAN pic.twitter.com/fgKH3qvjA2

— Higgsfield AI (@higgsfield_ai) March 31, 2025

THROUGH OBJECT OUT pic.twitter.com/GOutIZ5L7N

— Higgsfield AI (@higgsfield_ai) March 31, 2025

THROUGH OBJECT IN pic.twitter.com/VT6epL1YQI

— Higgsfield AI (@higgsfield_ai) April 5, 2025

LOW SHUTTER pic.twitter.com/cTTpO7fmhB

— Higgsfield AI (@higgsfield_ai) April 5, 2025

FOCUS CHANGE pic.twitter.com/wt8DwHzntT

— Higgsfield AI (@higgsfield_ai) April 5, 2025

LAZY SUSAN pic.twitter.com/IkcdeLFgT1

— Higgsfield AI (@higgsfield_ai) April 5, 2025

BUCKLE UP pic.twitter.com/6A1Q7rTo12

— Higgsfield AI (@higgsfield_ai) April 5, 2025

TENTACLES pic.twitter.com/BEIgjmQpiO

— Higgsfield AI (@higgsfield_ai) April 5, 2025

OBJECT POV pic.twitter.com/aJq2aD8eRo

— Higgsfield AI (@higgsfield_ai) April 5, 2025

2つのモーションコントロールを1ショット内に実現する「Higgsfield Mix」

Now, camera work isn’t limited by physics.

— Higgsfield AI (@higgsfield_ai) April 10, 2025

Introducing Higgsfield Mix - combine multiple motion controls in a single shot, including moves that aren’t possible with real cameras.

Also dropping 10 new motion controls built for speed, tension, and cinematic impact.

1/n pic.twitter.com/YpphhAkBid

4月11日(金)には、1ショット内で2つのモーションコントロールを組み合わせることができる「Higgsfield Mix」機能も実装された。

These motions can be used on their own or combined through Mix.

— Higgsfield AI (@higgsfield_ai) April 10, 2025

You can now build shots with shifts, angles, and transitions that would be physically impossible to pull off on set — but feel seamless in generation.

It opens a new kind of visual language.

4/n pic.twitter.com/EIBelXnycI

With Mix, you can combine motion controls in ways that don’t exist on set - crane over the head into crash zoom in, or a snorricam with a low shutter.

— Higgsfield AI (@higgsfield_ai) April 10, 2025

The result feels more authored, more complex, and more true to how real cameras move in commercial work.

2/n pic.twitter.com/eDwn9wEdlL

New challenge!

— Higgsfield AI (@higgsfield_ai) April 10, 2025

Create a video using Mix, drop it in the replies (with your motion combo specified), RT/QT this thread + follow us.

We’ll pick 3 winners next Friday for a free 1-month PRO subscription.

Let’s see what impossible shots you make.

5/n pic.twitter.com/pbreS1m7U5

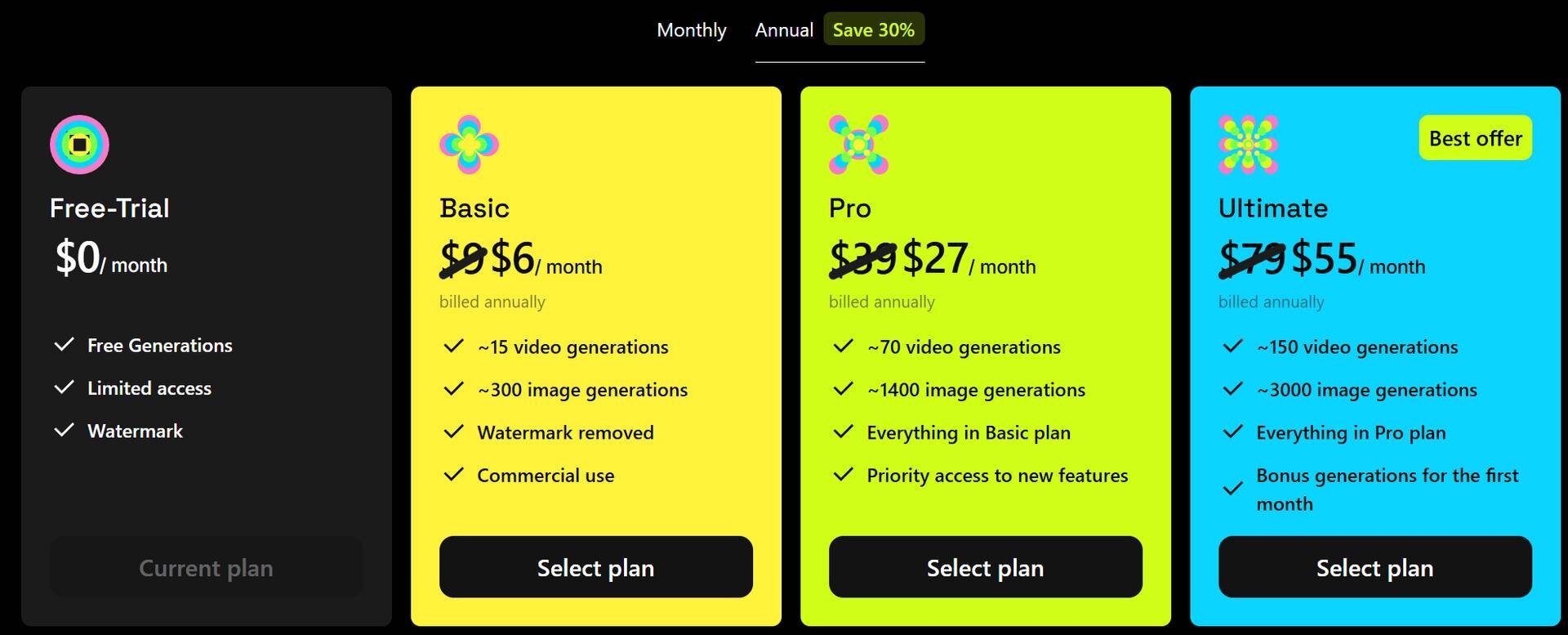

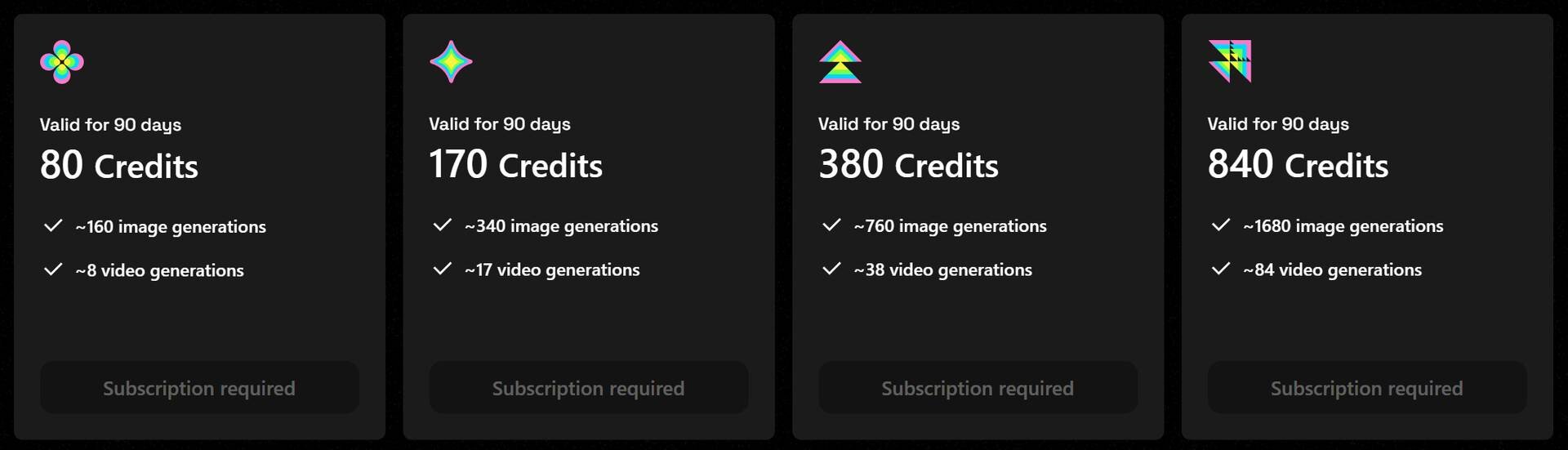

プランと価格

有料プランはBasic、Pro、Ultimateの3種類が用意され、Basicは月9ドル(約1,300円、年払いで月6ドル)でウォーターマークなし、商用利用可の動画が月15本生成でき、月150クレジットが付与される。

Free-Trialプランでは25クレジットが付与され、50枚までの画像生成、2本までの動画生成が行える。

クレジットは1枚の画像生成で0.5、1本の動画生成で10を消費する。有料プランのユーザーは、クレジットの追加購入も可能。

CGWORLD関連情報

●Metaら、映画レベルの自然な発話アニメーションが生成できるAIモデル「MoCha」発表! 自然言語・音声入力から直接対話アニメーションを生成可能

Metaとウォータールー大学の研究チームが、自然言語や音声入力から直接キャラクターの動作や表情を伴う発話アニメーションを生成できるDiTモデル「MoCha」を発表。

https://cgworld.jp/flashnews/01-202504-MoCha.html

●Runway、動画生成AI「Gen-4」リリース! 一貫性・忠実性・制御性の向上、ダイナミックなモーションを実現

Runway AIが動画生成AI「Gen-4」をリリース。Gen-3 Alphaよりもシーン内で一貫性のあるキャラクターやロケーション、オブジェクトを正確に生成できるようになったほか、シーン内の複数の視点や位置から首尾一貫した環境を維持した映像の再生成にも対応する。Gen-4の利用には有料プランのサブスクリプションが必要となる。

https://cgworld.jp/flashnews/01-202504-Runway-Gen-4.html

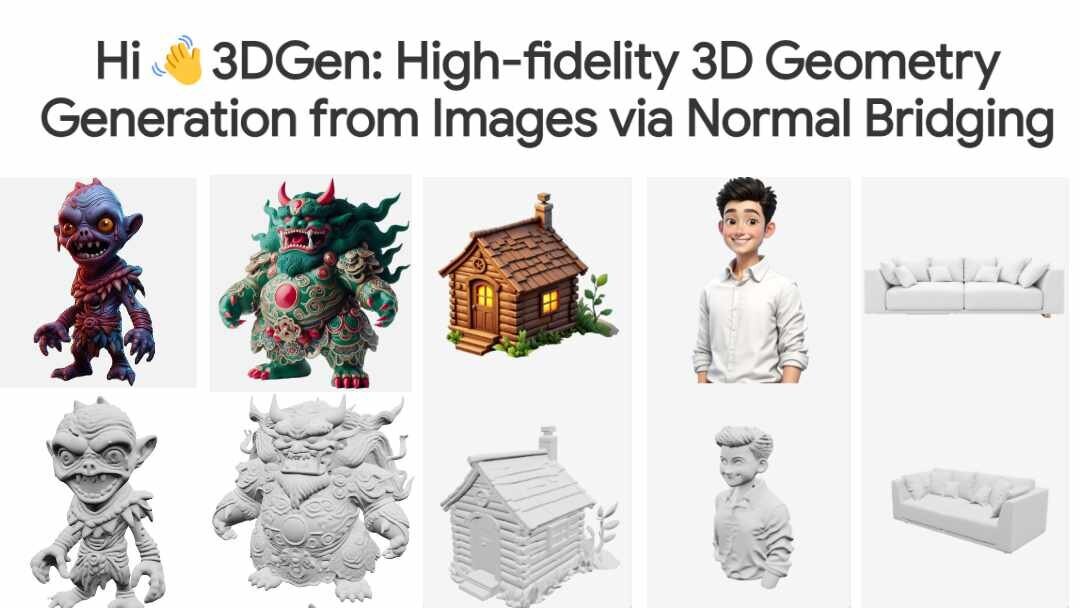

●3Dモデル生成AI「Hi3DGen v0.1」公開! 中間表現としてノーマルマップを使用することで高精細な3Dジオメトリの生成が可能に

香港中文大学(深圳)、ByteDance、清華大学の研究チームがオープンソースの3Dモデル生成AIプロジェクト「Hi3DGen: High-fidelity 3D Geometry Generation from Images via Normal Bridging」の論文を発表。Hi3DGen v0.1のモデルはHugging Faceのスペースでも公開されている。

https://cgworld.jp/flashnews/01-202504-Hi3DGen.html