Metaとウォータールー大学の研究チームは4月1日(火)、自然言語や音声入力から直接キャラクターの動作や表情を伴う発話アニメーションを生成できるDiTモデル(Diffusion Transformer、拡散モデルとトランスフォーマーを組み合わせた画像生成モデル)、「MoCha」を発表した。

Thrilled to introduce MoCha: Towards Movie-Grade Talking Character Synthesis

— Cong Wei (@CongWei1230) April 1, 2025

Please unmute to hear the demo audio.

We defined a novel task: Talking Characters, which aims to generate character animations directly from Natural Language and Speech input.

We propose… pic.twitter.com/Z991hE5GBx

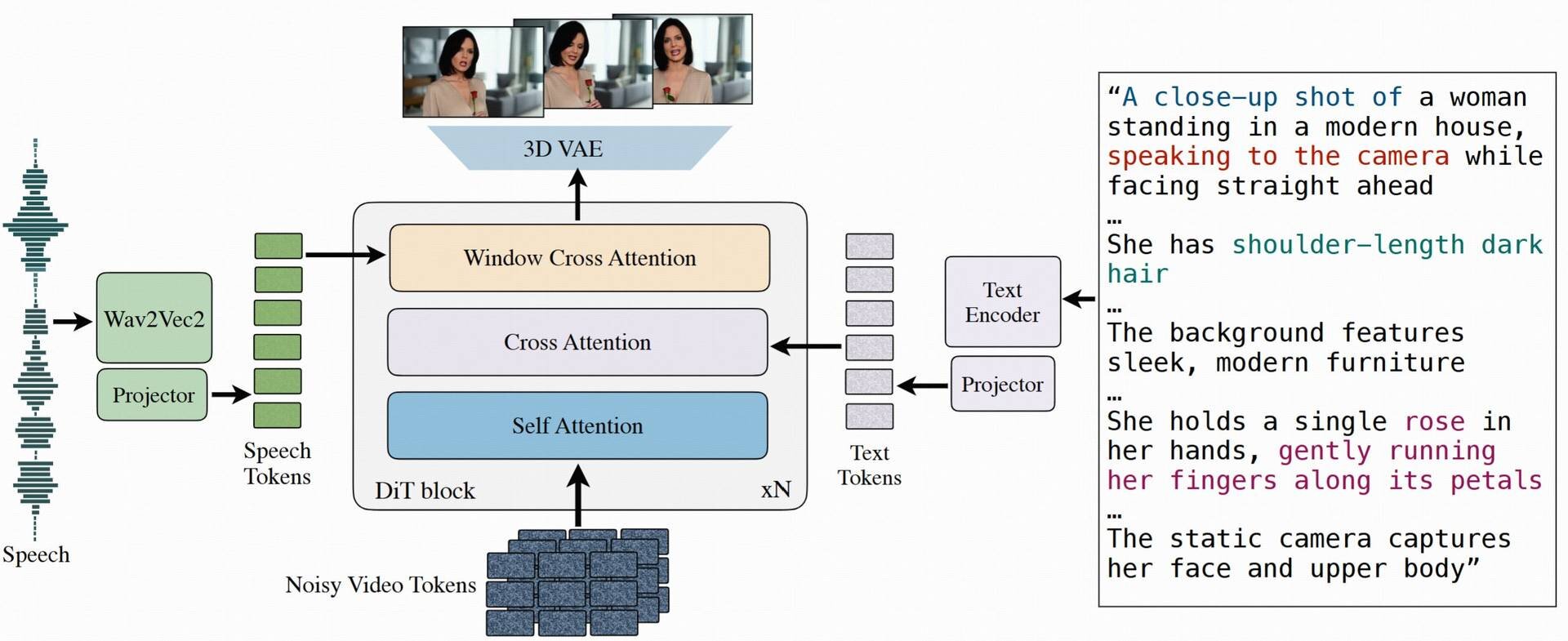

MoChaはテキストプロンプトによる指示と音声入力からエンドツーエンドで直接学習を行い、テキスト・音声・動画を全てトークンに投影し、3D VAE(Variational AutoEncoder)により合成するDiTモデル。

テキストプロンプトにはキャラクターと環境、行動などの情報を記述し、そうした情報から生成されたキャラクターに対して、音声データを用いてリップシンクと表情作成、動作生成を行う。

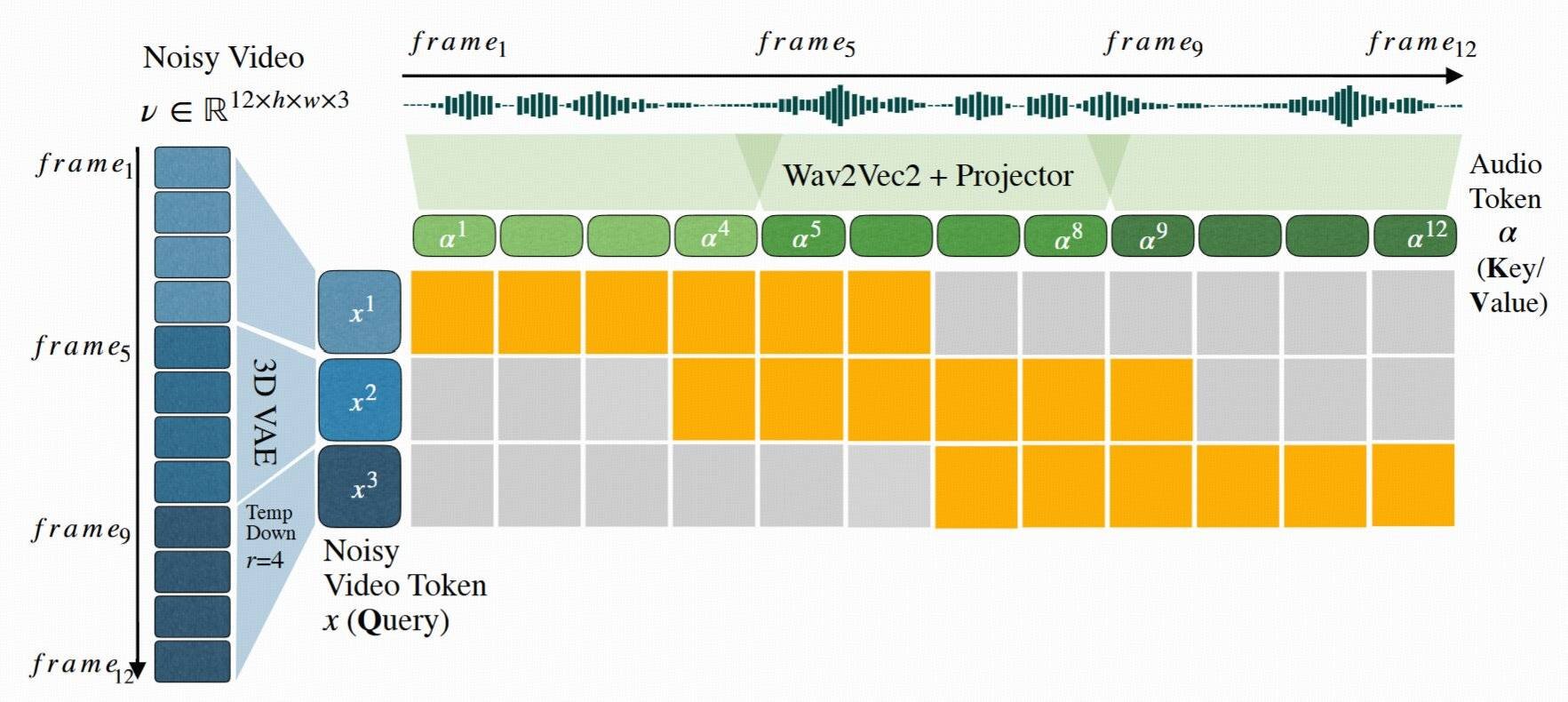

音声と動画の正確な同期、特にリップシンクの生成には「Speech-Video Window Attention」という仕組みを利用している。これは、音声と動画のデータを「小さな時間的範囲(ウィンドウ)」ごとに処理し、局所的に同期を取るというもの。これにより、リップシンクの精度が向上する。

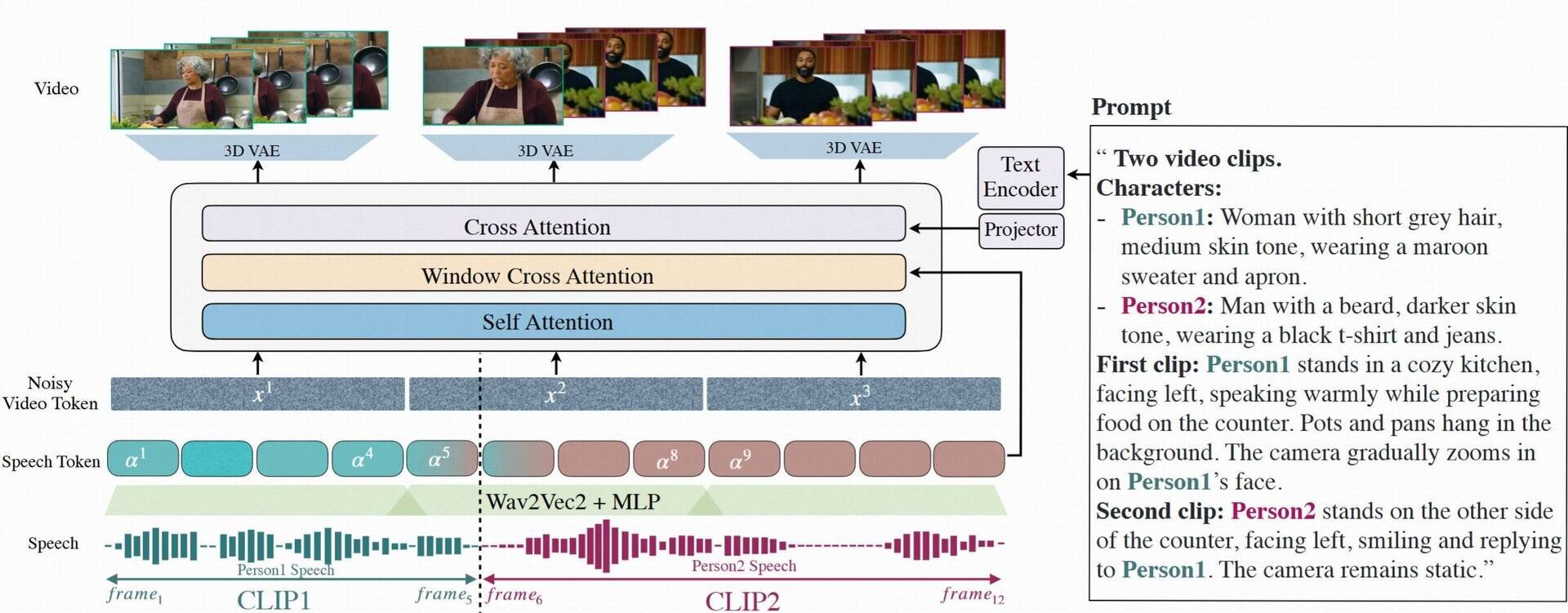

また、MoChaでは複数のキャラクターが順番に会話する「ターン制の対話」(Multi-Character Conversation Generation)の生成が可能。構造化されたプロンプトテンプレートを使用して各キャラクターにタグを付けることにより、会話のながれを自然に管理できるという。

なお、音声データが少ない場合にはテキストデータも活用して共同でトレーニングできるため、汎用性が高い。

研究者らは、MoChaによって複雑なキャラクターがより簡単に生成できるようになることから、映画やアニメーション、ゲーム、バーチャルアシスタントなど、多分野での応用を期待している。

今後の研究方針としては、より複雑なシーンや複数キャラクター間のインタラクション、長時間のストーリーテリングなどの課題に取り組むという。

下記プロジェクトページには、感情やアクションのコントロール、複数キャラクターによるターン制の会話シーンなど、多数の生成サンプル動画が公開されている。なお、現時点でMoChaで生成された動画は研究デモだけを目的としており、商用利用などは想定していない。

■MoCha: Towards Movie-Grade Talking Character Synthesis(プロジェクトページ)

https://congwei1230.github.io/MoCha/

■arXiv論文PDF

https://arxiv.org/pdf/2503.23307

CGWORLD関連情報

●Runway、動画生成AI「Gen-4」リリース! 一貫性・忠実性・制御性の向上、ダイナミックなモーションを実現

Runway AIが動画生成AI「Gen-4」をリリース。Gen-3 Alphaよりもシーン内で一貫性のあるキャラクターやロケーション、オブジェクトを正確に生成できるようになったほか、シーン内の複数の視点や位置から首尾一貫した環境を維持した映像の再生成にも対応する。Gen-4の利用には有料プランのサブスクリプションが必要となる。

https://cgworld.jp/flashnews/01-202504-Runway-Gen-4.html

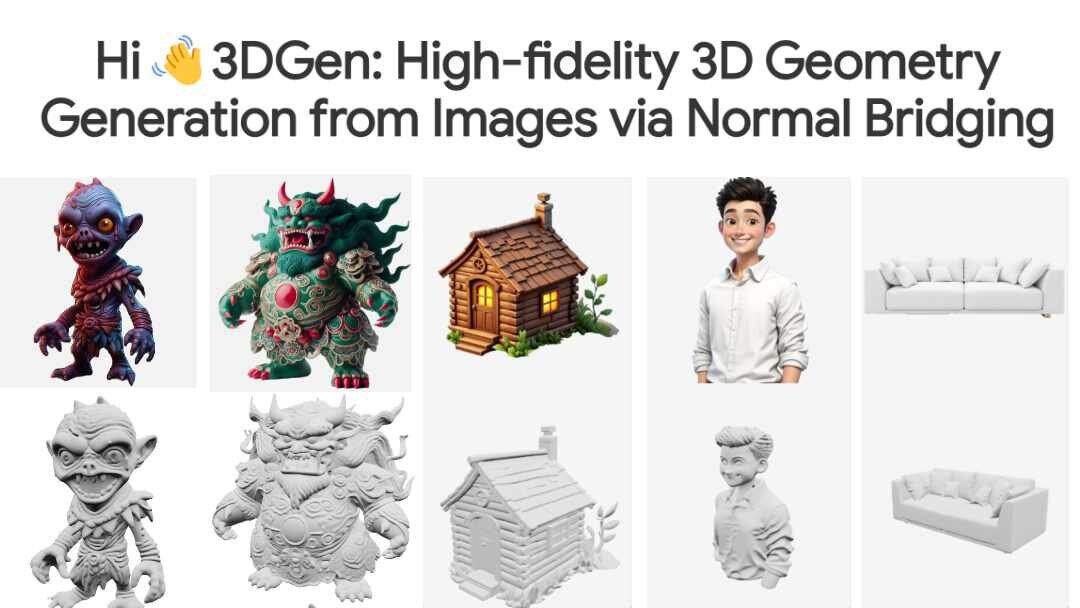

●3Dモデル生成AI「Hi3DGen v0.1」公開! 中間表現としてノーマルマップを使用することで高精細な3Dジオメトリの生成が可能に

香港中文大学(深圳)、ByteDance、清華大学の研究チームがオープンソースの3Dモデル生成AIプロジェクト「Hi3DGen: High-fidelity 3D Geometry Generation from Images via Normal Bridging」の論文を発表。Hi3DGen v0.1のモデルはHugging Faceのスペースでも公開されている。

https://cgworld.jp/flashnews/01-202504-Hi3DGen.html

●アドビ、Fireflyに加えGoogle Veo 2・Imagen 3、Flux 1.1 Pro、Runway FramesなどサードパーティAIモデルが選択可能に まずはAdobe Project Concept、Adobe Expressから

Adobeは同社製品で利用可能な生成AIモデルをAdobe Fireflyだけに制限せず、サードパーティ製AIモデルを選択可能にするとブログで発表。まずはAdobe Project ConceptとAdobe Expressで利用可能になるという。

https://cgworld.jp/flashnews/01-202504-Adobe-GenAI.html