8月22日(水)~24日(金)の3日間、ゲームを中心とするコンピュータエンターテインメント開発における国内最大のカンファレンスCEDEC 2018がパシフィコ横浜で行われた。本レポートでは、「1万人規模音楽ライブからトークイベントまで、バーチャルキャラクターをリアルイベントへ召喚する技術」と題して、バーチャルキャラクターを使用したイベント構築について俯瞰的に説明された株式会社バーチャルキャストの講演の様子をお伝えする。

関連記事

プログラマーこそHoudiniを触るべき!~プログラマー目線での魅力が熱く語られたHoudiniトーーク~CEDEC 2018レポート(1)

ノードベースのVFX制作は怖くない! 日米協業タイトルで実現したUbisoftの取り組み~CEDEC 2018レポート(2)

TAを増やす改善策は「余裕をもつこと」~若手テクニカルアーティストが大いに語ったラウンドテーブル~CEDEC 2018レポート(3)

『ウイニングイレブン 2019』Enlightenの導入が実現した効率的なライティングワークフローとは~CEDEC 2018レポート(5)

TEXT&PHOTO_神山大輝 / Daiki Kamiyama(NINE GATES STUDIO)

EDIT_小村仁美 / Hitomi Komura(CGWORLD)

<1>バーチャルキャラクターをリアルへ召喚するための技術的4要素

登壇したのは株式会社バーチャルキャスト CTO 岩城 進之介氏。岩城氏はもともと株式会社ドワンゴでマルチメディア企画開発部 先端演出技術開発セクション セクションマネージャというポジションで、VRライブハウス「ニコファーレ」(2011〜)や『超歌舞伎』(2016〜)などのイベント演出、AR/VRの開発を担当してきたが、現在は2018年7月27日付で設立された株式会社バーチャルキャストのCTOとなっている。

岩城 進之介氏(株式会社バーチャルキャスト CTO)

本講演では、バーチャルキャラクターをイベントへ召喚するための必要な技術要素と、技術を選ぶ基準、大型イベントならではの落とし穴、そしてバーチャルキャラクターならではの気をつけるべきポイントについて俯瞰的に説明された。岩城氏ははじめに「バーチャルキャラクターは技術的にも面白いので、ついつい凝ったことをやりがちです。ですが、最終的なゴールは来場者を楽しませることなので、技術だけを追い続けるのではなく本質を忘れないようにしましょう」とイベント全般の目的について説明した。

バーチャルキャラクターを召喚するための技術的な要素は、「キャラクターの動きをどうつけるか」、「キャラクターをどう出現させるか」、「キャラクターアクターにどう演じてもらうか」、「イベント全体をどう成立させるか」の4点に大別される。

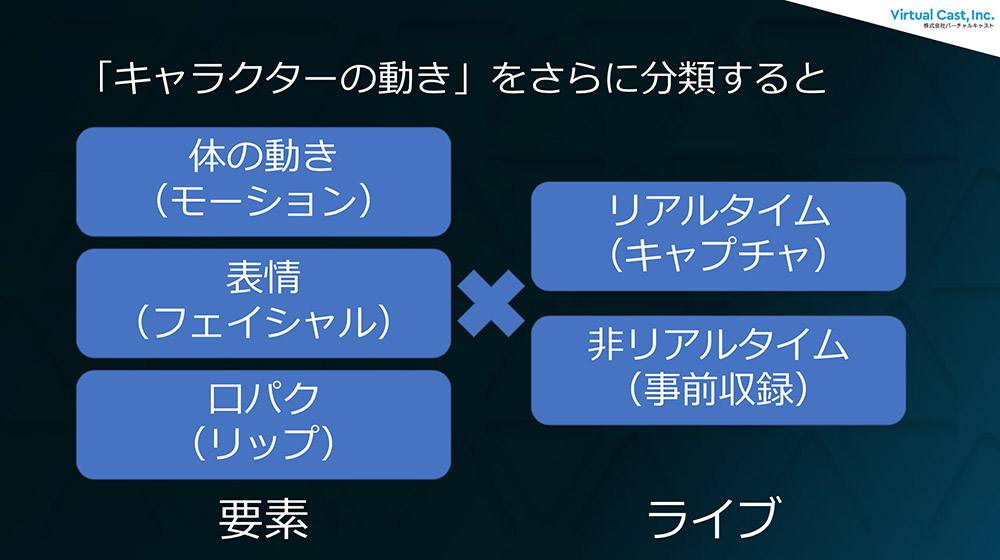

まず、キャラクターの動きをつかさどるモーションキャプチャは、「身体の動き=モーション」、「表情=フェイシャル」、「口パク=リップ」という3要素に分けて考えられる。そして、これらはリアルタイムキャプチャか、事前収録による非リアルタイムかによっても区分される。

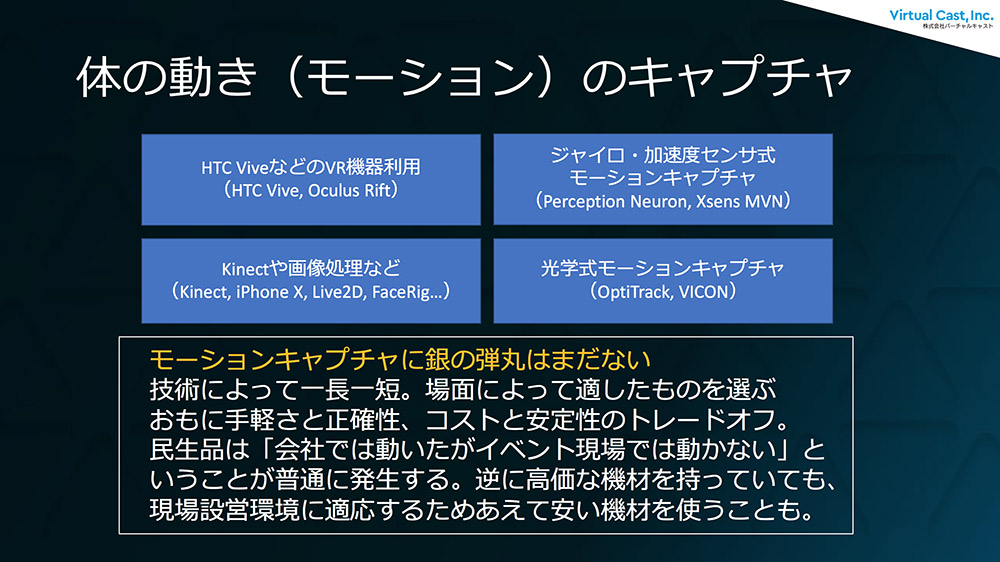

身体の動きは、以下4点の表現方法がある。

- ・HTC Vive、Oculus RiftなどのVR機器利用

- ・Perception Neuron、Xsens MVNなどのジャイロ・加速度センサ式

- ・Kinectや画像処理などのカメラを使って撮影をするもの

- ・OptiTrack、VICONなど光学式モーションキャプチャ

この4種類は一長一短で、現段階ではこれを使えば絶対間違いないという「銀の弾丸」はないという。そのため、用途に合わせて適宜使い分ける必要がある。例えばHTC Viveの場合は、安価かつ簡単に使える上にViveトラッカーを複数付けることで全身を綺麗にキャプチャできるが、イベント現場ではViveトラッカーのバッテリ管理が難しい。また、混線によるトラブルも多い。ジャイロ・加速度センサ式も手軽だが、磁気や地場環境にかなり依存してしまうため、業務で使用するのは厳しいという。

また、近年バージョンアップで安定性の増したMVNも、ジャイロ誤差で徐々に原点からズレてしまう問題もあり、キャラクターの立ち位置が詳細に決まっている舞台の場合は原点位置を補正する必要がある。これらに比べて光学式モーションキャプチャは快適に用いられるが、使うスペースが大きく設営が非常に大変。光学式が使える環境なら光学式を使ったほうが良いが、設営の観点から見てその他のシステムを用いるシーンも多いという。

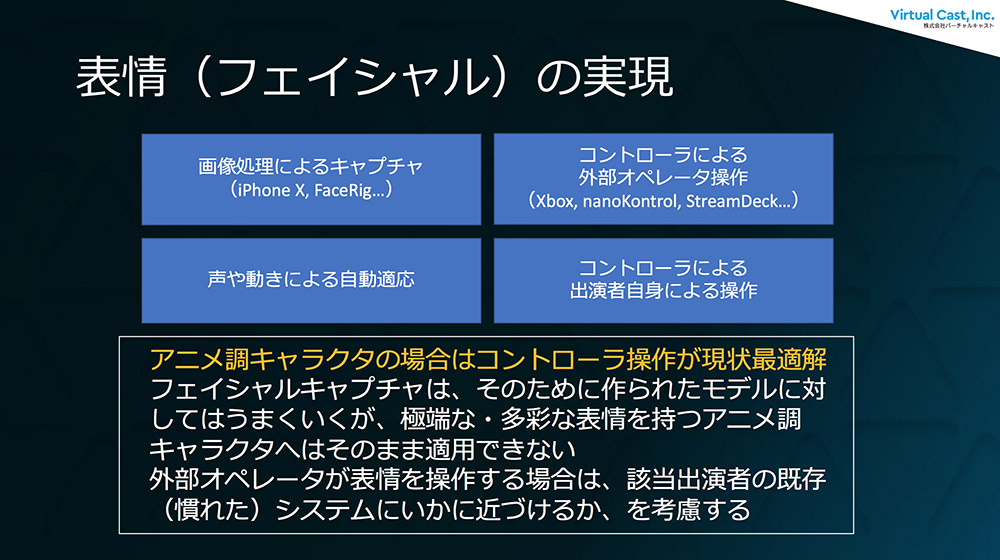

表情(フェイシャル)の表現は、現在は外部オペレーターによるコントローラ操作が一般的だが、中にはワンオペ向けに出演者自身が操作するものも存在する。ViveコントローラやOculus Touchの各ボタンに表情を割り当てて対応することも可能だが、多くの場合はクオリティが演者自身の操作慣れに依存するため、表情を担当する外部オペレーターがいると良いとのこと。

そして、リップシンクについては、現時点では音声からリップシンクを自動生成するのが定石となっており、OculusのリップシンクライブラリOVRLipSyncなどを用いて、話している声を基に口パクを生成するというのが「一番しっくりくる」という。また、イベント会場では他の音と混ざらない環境をつくったり、アクターにモニターバックをする環境を構築する必要もあるため、ソフトウェアエンジニアが環境構築を行うのではなく音周りのプロに一任した方が良いとも説明された。

また、リアルタイムなのか事前収録なのかという点については、「イベントの場合は基本的にリアルタイムが面白いです。観客とのコミュニケーションが特に重要なので、ここを重視しています。ただ、例えば高難易度のダンスなどリアルタイムでは難しいものは事前収録を行なっておいて、モーションブレンドですり替える、ということもあります」と説明された。リアルタイムから事前収録に差し替える場合は、指差しなどの決めポーズに移行する際に切り替えると、切り替えがわかりにくいという。

次ページ:

<2>キャラクターの世界観に合わせたディスプレイ選択

<2>キャラクターの世界観に合わせたディスプレイ選択

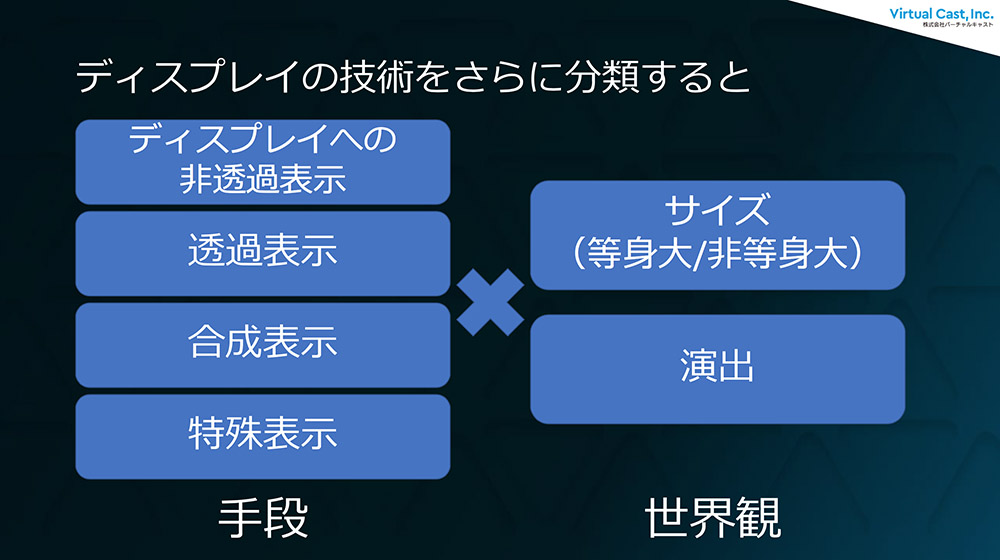

続いてはディスプレイについて。通常のモニタにキャラクターを投影する非透過表示、透過スクリーンやハーフミラーを用いる透過表示、配信・生放送用のARによる合成表示、そして特殊表示と4種類の手段があるが、岩城氏はキャラクターに合った世界観が最も重要だと言う。

「技術よりは、"そのキャラクターがどうしてそこにいるのか?"をきちんと考えるべきです。例えば出ハケ(舞台に登場することと、舞台から退場すること)に関しても、どういうふうに出てくるかを意識しなくてはいけません」(岩城氏)。キラキラしたパーティクルに包まれての登場は、「そういう世界観をもっているキャラクター」なら許されるが、そうでない場合は歩いて出てくる、暗転で消えるなど、キャラクターの世界観と合った演出を考えなくてはいけないと続けた。

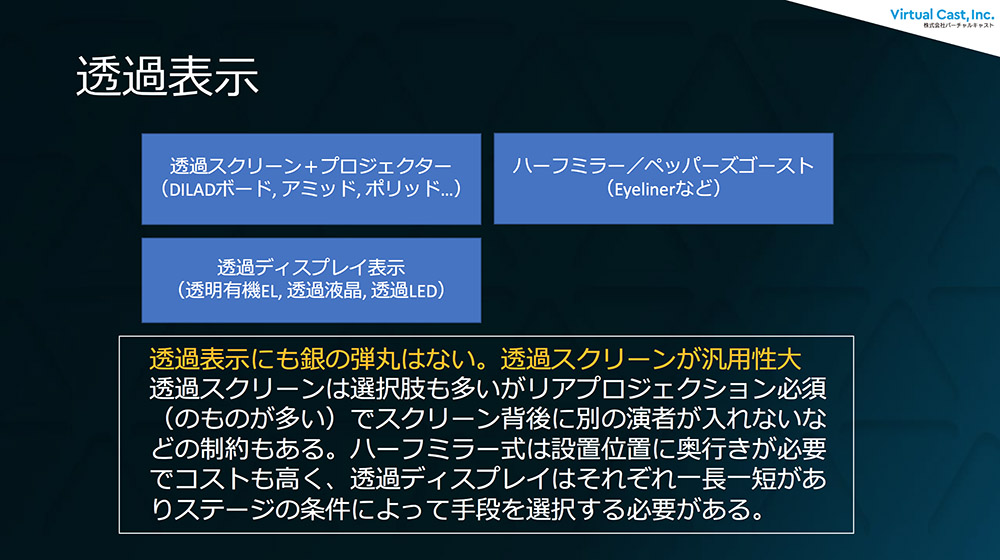

また、透過表示についてもモーションキャプチャ同様、これを使えば万事解決するというソリューションはなく、それぞれの短所を理解した上で用いるべきだと説明された。例えば半透明なスクリーンに対してプロジェクタを当てる場合は、後ろの壁への映り込みを避けるために背面側から投影を行うが、そのためには投影距離を十分に取るためにステージの広さが必要となる。また、ハーフミラーの場合も、ミラーの奥側に立っているように見えるためその間に人が入ることができず、ステージ上での動線に制限を生んでしまう。周りの照明の明るさやステージの広さ、ステージ上での演者の動きを加味して、使用するツールを選定する必要がある。

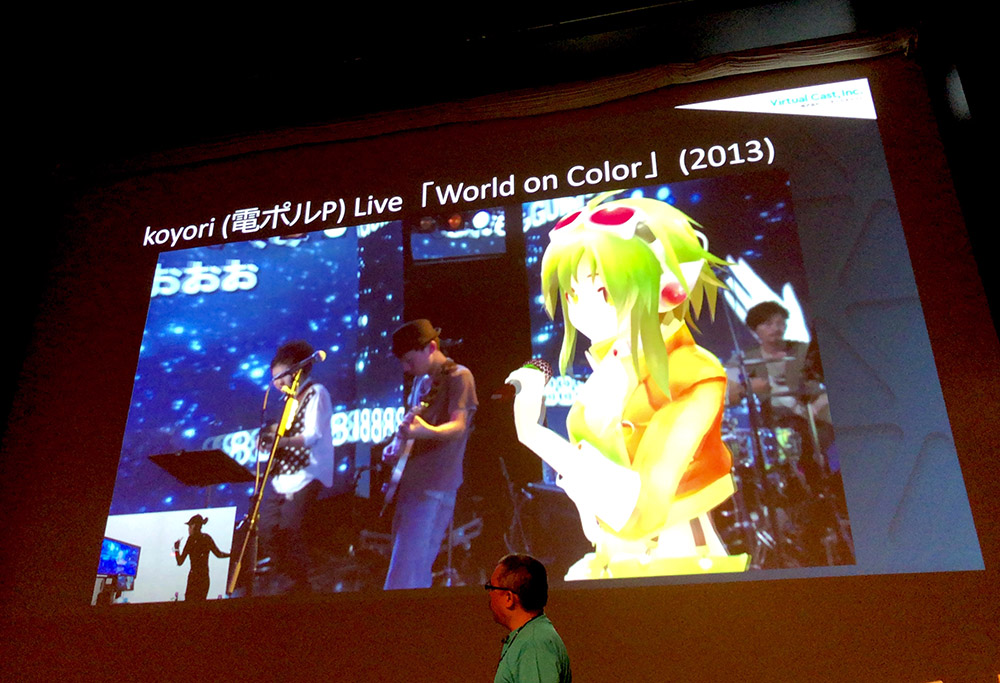

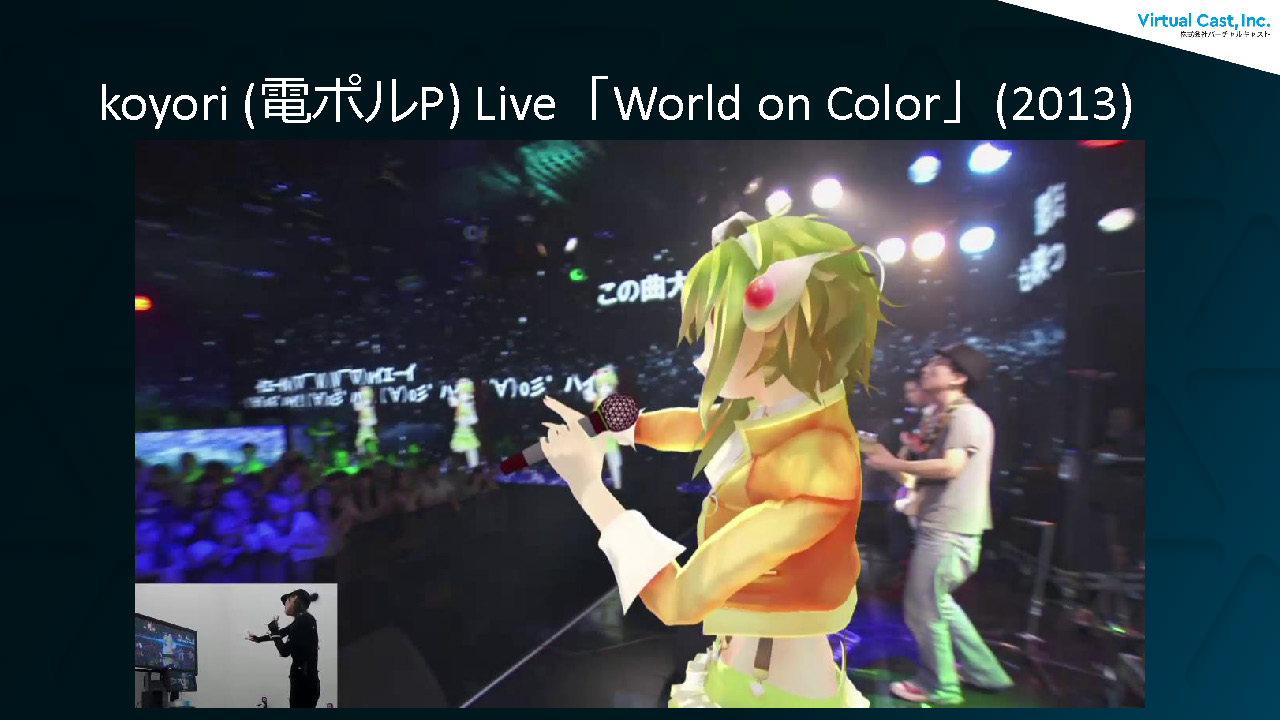

続いていくつかの事例が紹介された。『Voca Nico Night Live Stage in nicofarre』(2012)では、ニコファーレの裏側でOptiTrackを用いてモーションキャプチャをしており、口パクは自動生成となっている。なお、以下の画像は実際の配信画面で、ステージに表示されたバーチャルキャラクターとは別に、キャラクターが配信映像にオーバーライドされている。また、『koyori(電ポルP) Live「World on Color」』(2013)では、Wiiリモコンのボタンで表情が変えられるようになっており、アクターの横でオペレーターが操作を行なっている。

「Voca Nico Night Live Stage in nicofarre」(2012)

koyori(電ポルP) Live「World on Color」(2013)

また、配信特化のコンテンツとしてキャラクターが配信画面のみに映る『IA生誕3周年LIVE We gotta run | IAxJumicchi』(2015)、特殊表示の事例として『ニコニコ超パーティ2016 VOCALOIDライブ』(2016)でのスモークに投影された初音ミクの映像が紹介された。煙が消えるとあっという間に別スクリーンに移っていくという、スモークの特性を活かした演出となっている。

【IA生誕3周年】We gotta run|IA×Jumicchi 【LIVE】

次ページ:

<3>キャラクターアクターに演じてもらうアクト環境の構築

<3>キャラクターアクターに演じてもらうアクト環境の構築

声優に動きの演技までを求めるのは難しいという理由からボイスアクターとモーションアクターは別の人が演じることも多いが、そういったケースでは両者の意思疎通をどうするかが課題となる。表情もモーションアクターが付けるのか、ボイスアクターが担当するのか、ケースバイケースでアクターの配置が変わる上、イベントだと機材面だけでなく舞台監督や進行、ディレクターが存在するために指示系統を明確にしておく必要もある。このように「意思が流れる経路」を意識して現場の配置を行う必要があると岩城氏は説明する。

また、イベントの場合はアクターの視界をどうするかという問題もある。イベント中に観客とコミュニケーションを取るのであれば、キャラクターの絵も含めた客席映像をアクターが確認できなければならない。会場の様子を映すカメラに関しても、配線の都合などでアクター側から客席側にカメラを向けられない場合は後ろから撮影を行うことになるが、こうした場合は映像を左右反転する必要がある。

加えて、会場に光学式モーションキャプチャを置く場所がない、つまりステージと同じだけの広さのキャプチャエリアがバックヤードに確保できないこともあるため、遠隔出演を行うケースもある。高度に同期した演目があるか、またアクターが会場の雰囲気を肌で感じる必要があるかなどで判断を行うが、遠隔の場合は舞台進行に関わるスタッフの負荷が高いことにも注意したい。

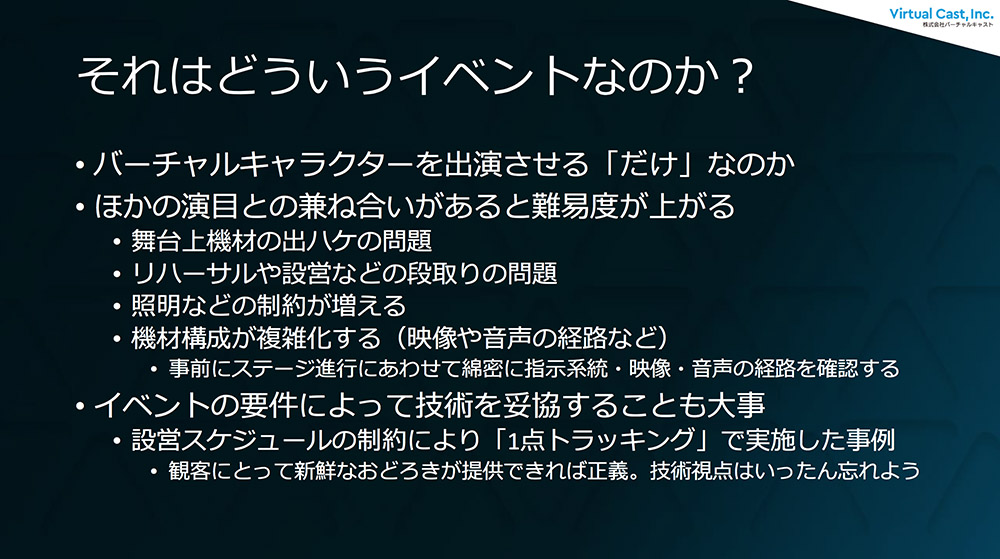

<4>「どういうイベントなのか?」を考える

バーチャルキャラクターを出演させることだけが目的なら話は簡単だが、現在はより高度な演出を求められることも多い。「様々なアクターや演目がある中の1項目としてバーチャルキャラクターを出したい、という要求だと一気に難易度が上がります。システムはステージ上で場所を取るため、出しっ放しにして他の演目ができるか? できないのであれば、どう片付けるのか? なども課題となります」(岩城氏)。

こうしたイベントはリハーサルや設営などの段取りも含めて全体のスケジュールが厳密に決まっているため、検証に時間をかけることは難しい。そのため、最初に述べられた通り「お客さんが喜ぶこと」をゴールとし、設営時間や環境を加味して技術を妥協することも重要だと説明された。例示されたのは、頭にトラッカーを付けただけの1点トラッキング。顔を向いているかだけを検知し、他の動きは収録されたものをスイッチャーで出すことで補完、アクターは映像を見ながら喋るかたちとなったそうだが、岩城氏いわく「結局、お客さんに好評だったので、勝ちです」とのことだった。

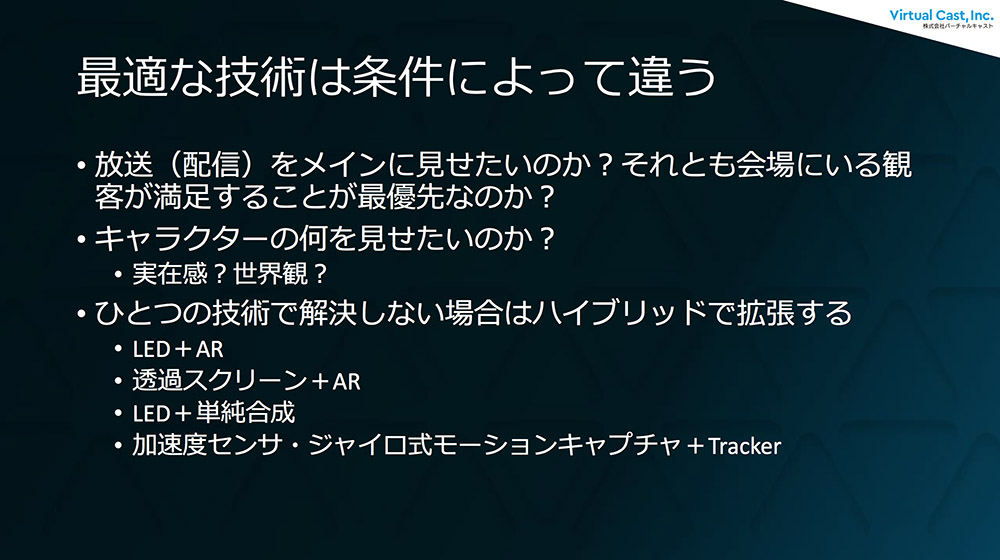

また、最適な技術は条件によって異なるため、キャラクターの何を見せたいのか----実在感なのか、世界観なのか、世界観や条件を吟味してツール選定を行うべきだとも語られた。MVNだけでは原点がずれる場合は光学式モーションキャプチャを用いて補正を行う、ARを上から重ねるなど、弱点を補強する組み合わせを用いることも多いという。

そして大規模な会場では音響にせよ照明にせよ緻密な調整が必要になる。「舞台には舞台のプロがいて、お互いが独自の共通言語をもち高速に意思疎通をしています。それに合わせるのは無理なので、やりたいことをこちらが説明して、その上で判断を仰ぐのが良いと思います」(岩城氏)。ただ、譲れないポイントは事前に決めておくべきだとも説明された。例えば、ARキャラクターを現地での照明を反映するようにつくっている場合は、照明の方と演者に影を落とすなどの相談を行う場合はあるという。

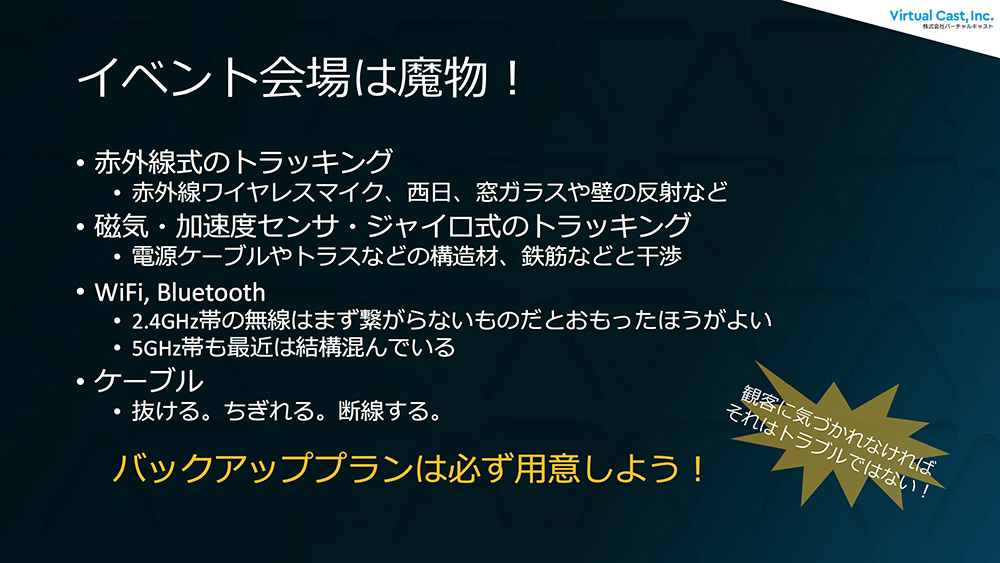

また頻繁に言われるのが、"ステージは魔物"ということ。テストでは上手く動いていても、現地では動かないということはよくあるため、バックアッププランは必ず用意すべきだと岩城氏は語る。例えばステージの床がピカピカに磨かれているとマーカーが見えてしまったり、無線の場合は混線したり、磁気モーションキャプチャが乱れることもある。無線はまず使えないと思った方が良いため、Viveトラッカーも現場では用いない方が良いとも説明された。また、ケーブルも「抜ける、ちぎれる、断線する」というケースは良くあるため、予備は必ず用意すべきだと強調された。

[[SplitPage]]<5>技術的にトリッキーなキャラクター召喚事例

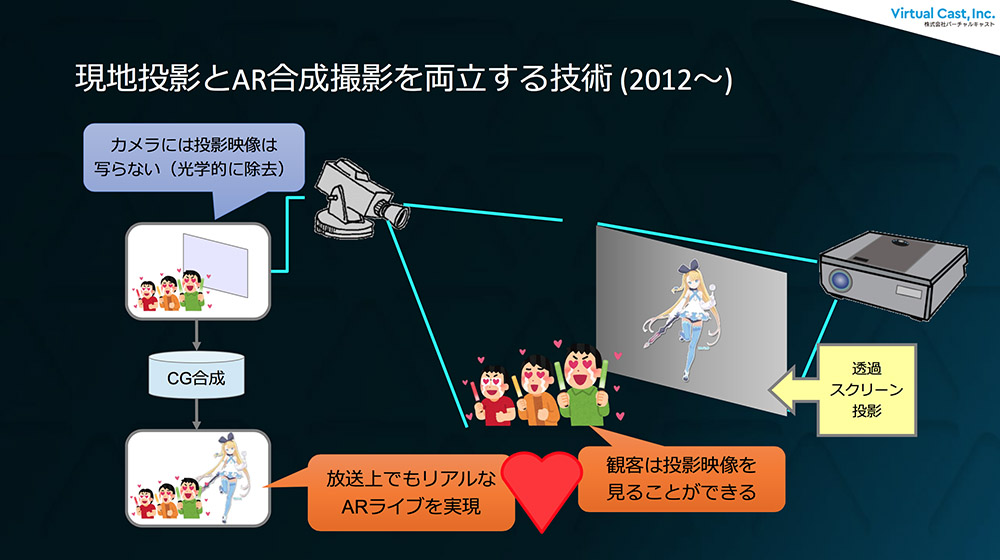

その後は、"技術的にトリッキーな事例"の紹介が行われた。『ニコニコ超パーティ2015 AR×透過スクリーン×360度』(2015)では現地映像と配信映像が異なっており、現地の観客は透過スクリーンでキャラクターを見ているが、配信ではAR合成が行われており360度カメラを回転させることが可能となっている。なお、モーションキャプチャは現地でのMVNによるリアルタイム収録。

『電脳少女シロ~E3に行く!?~』(2018)では、ARライブシステムをフルバッテリ&無線駆動でパッケージングしており、モニタ1つで現地の方へのインタビューも行えるようなしくみを採っていた。

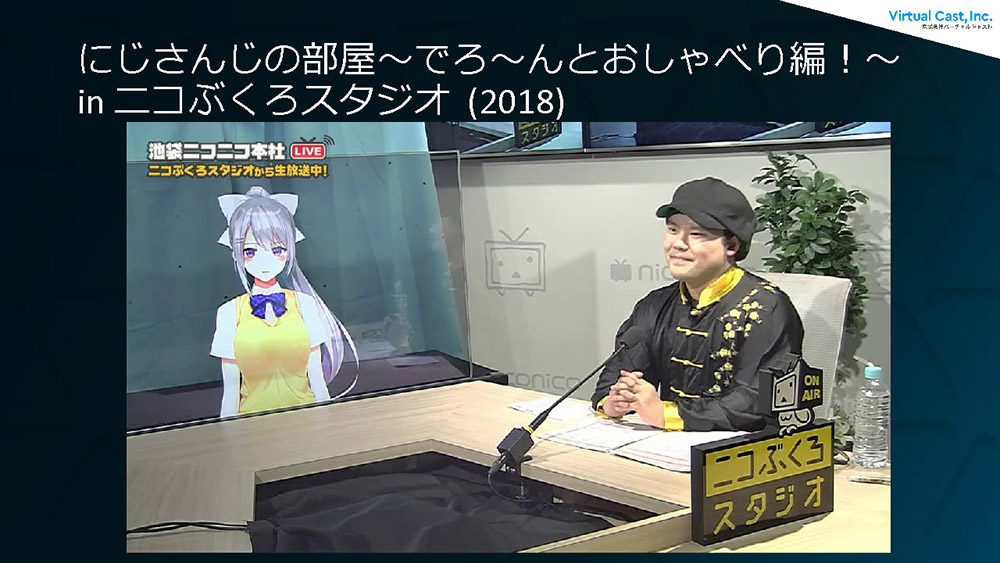

『にじさんじの部屋~でろ~んとおしゃべり編!~ in ニコぶくろスタジオ』(2018)はラジオの公開収録にバーチャルキャラクターが登場するという事例。透明な有機ELは裏側から見ると向こう側が透けるため、その特性を活かして裏側に視点用のカメラを置くことで「そこにいるかのようなカメラ視点」が得られると岩城氏は説明する。

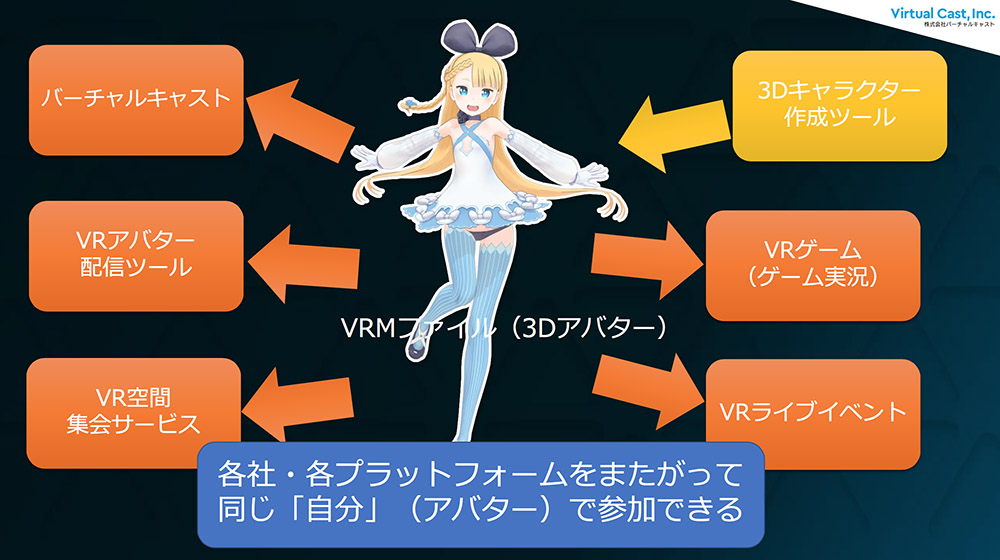

講演の最後に、岩城氏はバーチャルキャラクターを取り巻くイベントの今後について、3Dアバターフォーマット「VRM」を含めて解説した。VRMはドワンゴが提唱する3Dモデルのデータフォーマットで、細かいモデルデータのちがいを吸収し、様々なソフトウェアで活用できるようにするしくみ。従来はFBX形式でつくったモデルデータをアプリケーションごとに設定を変えながら用いていたが、VRMなら単一ファイルで全てに対応可能となる。

その結果、「モデルデータと演出が別々に開発できるようになった」と岩城氏は説明する。これまではモデルデータを確認しながらシステムひとつひとつをチューニングする必要があったが、モデル規格が画一化されればシステムはシステムとして独立して開発できるようになるという。つまり、イベントで活用するシステム基盤を汎用化することができるというわけだ。バーチャルキャラクターを取り巻く環境を俯瞰的に説明した本講演。岩城氏は「リアルとバーチャルの境目は、技術で乗り越えられます。積極的に境目を溶かしていきましょう!」と語り、講演を締めくくった。